Divisão da computação em IA: os cientistas não têm acesso a chips poderosos para suas pesquisas

Acadêmicos de todo o mundo estão lutando contra o poder computacional insuficiente para pesquisas em IA. Pesquisa mostra grandes diferenças no acesso a GPUs.

Divisão da computação em IA: os cientistas não têm acesso a chips poderosos para suas pesquisas

Muitos cientistas universitários estão frustrados com o poder computacional limitado disponível para suas pesquisas na área de inteligência artificial (IA) está disponível, como mostra uma pesquisa com acadêmicos de dezenas de instituições em todo o mundo.

Os resultados 1, publicado em 30 de outubro no servidor de pré-impressão arXiv, sugere que os acadêmicos não têm acesso aos sistemas de computação mais avançados. Isso pode afetar sua capacidade de modelos de linguagem grande (LLMs) desenvolver e realizar outros projetos de pesquisa em IA.

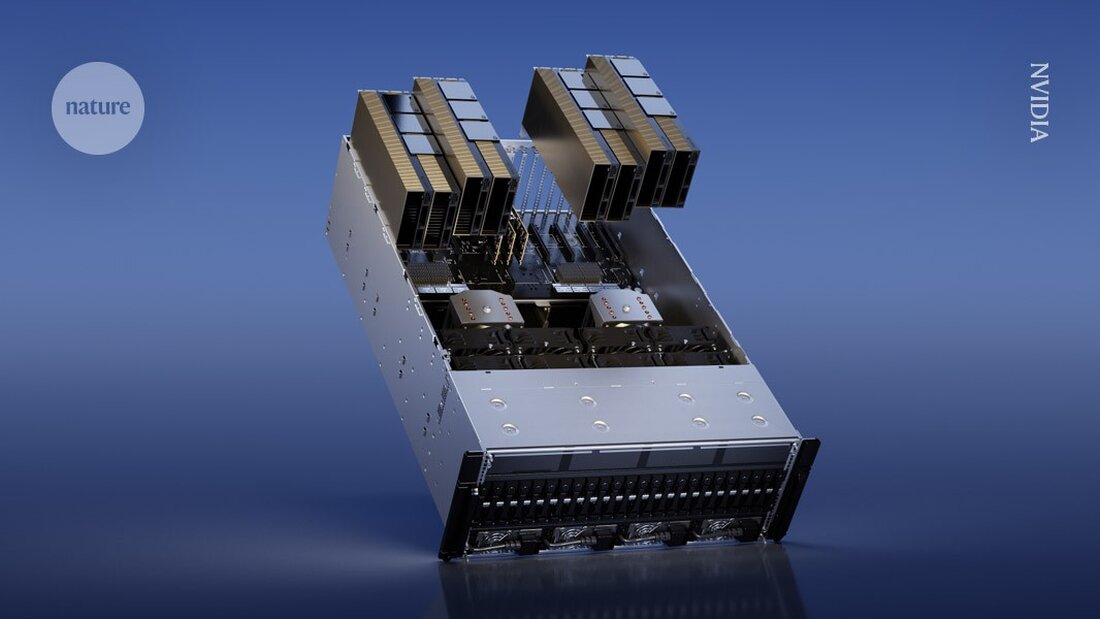

Em particular, os investigadores académicos por vezes não têm os recursos necessários para serem poderosos Processadores gráficos (GPUs) para comprar – chips de computador comumente usados para treinar modelos de IA que podem custar vários milhares de dólares. Em contraste, os investigadores de grandes empresas tecnológicas têm orçamentos maiores e podem gastar mais em GPUs. “Cada GPU adiciona mais potência”, diz o coautor do estudo Apoorv Khandelwal, cientista da computação da Brown University em Providence, Rhode Island. “Embora esses gigantes da indústria possam ter milhares de GPUs, os acadêmicos podem ter apenas algumas.”

“A lacuna entre os modelos acadêmico e industrial é grande, mas poderia ser muito menor”, diz Stella Biderman, diretora executiva da EleutherAI, um instituto de pesquisa de IA sem fins lucrativos em Washington DC. A investigação sobre esta desigualdade é “muito importante”, acrescenta ela.

Tempos de espera lentos

Para avaliar os recursos computacionais disponíveis para os acadêmicos, Khandelwal e seus colegas entrevistaram 50 cientistas de 35 instituições. Dos entrevistados, 66% avaliaram sua satisfação com seu poder computacional como 3 ou menos em uma escala de 5. “Eles não estão nada satisfeitos”, diz Khandelwal.

As universidades têm regulamentações diferentes para acesso a GPUs. Alguns podem ter um cluster de computação central compartilhado entre departamentos e estudantes onde os pesquisadores podem solicitar tempo de GPU. Outras instituições poderiam adquirir máquinas que possam ser utilizadas diretamente pelos membros do laboratório.

Alguns cientistas relataram ter que esperar dias para obter acesso às GPUs, observando que os tempos de espera eram particularmente altos em torno dos prazos dos projetos (consulte “Gargalos de recursos computacionais”). Os resultados também destacam as desigualdades globais no acesso. Por exemplo, um entrevistado mencionou a dificuldade de encontrar GPUs no Oriente Médio. Apenas 10% dos entrevistados disseram ter acesso a GPUs H100 da NVIDIA, para ter chips poderosos projetados para pesquisas de IA.

Esta barreira torna o processo de pré-formação – alimentar grandes conjuntos de dados em LLMs – particularmente desafiante. “É tão caro que a maioria dos académicos nem sequer considera fazer ciências na pré-formação”, diz Khandelwal. Ele e os seus colegas acreditam que os académicos oferecem uma perspectiva única na investigação em IA e que a falta de acesso ao poder computacional pode limitar o campo de investigação.

“É muito importante ter um ambiente de pesquisa acadêmica saudável e competitivo para o crescimento e o desenvolvimento tecnológico de longo prazo”, diz a coautora Ellie Pavlick, que estuda ciência da computação e linguística na Brown University. “Quando você faz pesquisas na indústria, há pressões comerciais claras que às vezes nos tentam a explorar mais rápido e explorar menos.”

Métodos eficientes

Os pesquisadores também examinaram como os acadêmicos poderiam fazer melhor uso de recursos computacionais menos potentes. Eles calcularam quanto tempo seria necessário para pré-treinar vários LLMs usando hardware de poucos recursos – entre 1 e 8 GPUs. Apesar desses recursos limitados, os pesquisadores conseguiram treinar com sucesso muitos dos modelos, embora demorasse mais e exigisse o uso de métodos mais eficientes.

“Na verdade, podemos usar as GPUs que temos por mais tempo e, assim, suavizar algumas das diferenças entre o que a indústria possui”, diz Khandelwal.

“É emocionante ver que é realmente possível treinar um modelo maior do que muitas pessoas poderiam imaginar, mesmo com recursos computacionais limitados”, diz Ji-Ung Lee, que estuda modelos neuroexplícitos na Universidade de Saarland, em Saarbrücken, Alemanha. Ele acrescenta que trabalhos futuros poderiam analisar as experiências de pesquisadores industriais em pequenas empresas que também lutam com acesso a recursos computacionais. “Não é como se todo mundo que tem acesso ao poder computacional ilimitado realmente o consiga”, diz ele.

-

Khandelwal, A. et al. Pré-impressão em arXiv https://doi.org/10.48550/arXiv.2410.23261 (2024).

Suche

Suche

Mein Konto

Mein Konto