Przepaść w informatyce AI: naukowcom brakuje dostępu do wydajnych chipów do celów badawczych

Naukowcy na całym świecie zmagają się z niewystarczającą mocą obliczeniową do badań nad sztuczną inteligencją. Ankieta pokazuje duże różnice w dostępie do procesorów graficznych.

Przepaść w informatyce AI: naukowcom brakuje dostępu do wydajnych chipów do celów badawczych

Wielu naukowców uniwersyteckich jest sfrustrowanych ograniczoną mocą obliczeniową dostępną im do badań w dziedzinie sztuczna inteligencja (AI) jest dostępna, jak pokazuje badanie przeprowadzone wśród naukowców w kilkudziesięciu instytucjach na całym świecie.

Wyniki 1, opublikowane 30 października na serwerze preprintów arXiv, sugerują, że naukowcom brakuje dostępu do najbardziej zaawansowanych systemów komputerowych. Może to mieć wpływ na Twoją zdolność duże modele językowe (LLM) opracowywać i realizować inne projekty badawcze w zakresie sztucznej inteligencji.

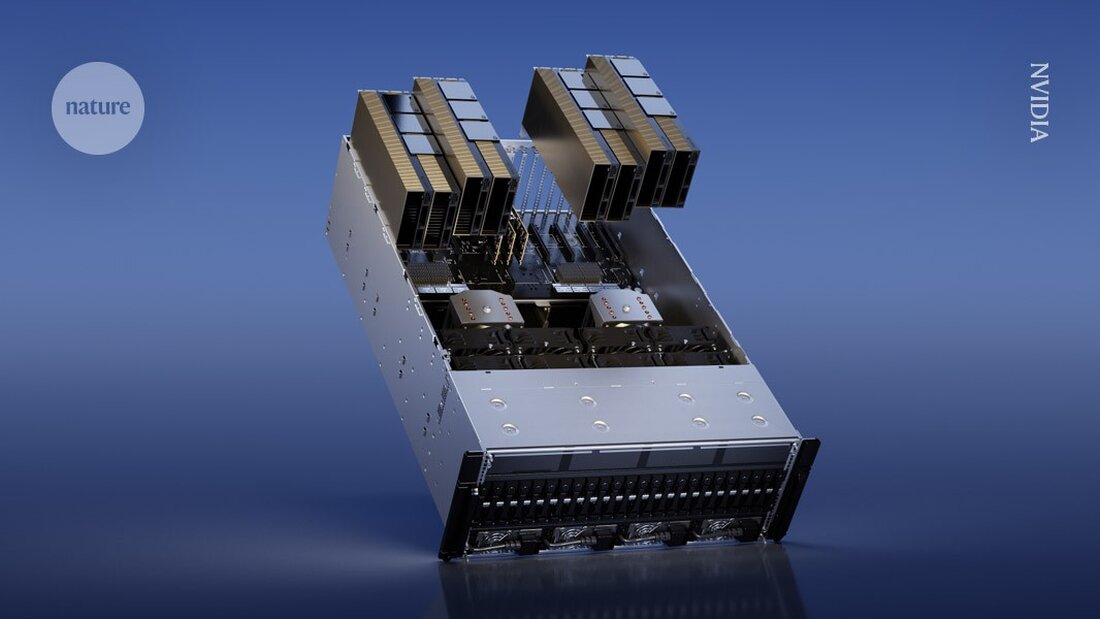

W szczególności badacze akademiccy czasami nie mają zasobów, aby być potężni Procesory graficzne (GPU) kupić – chipy komputerowe powszechnie używane do uczenia modeli AI, które mogą kosztować kilka tysięcy dolarów. Z kolei badacze w dużych firmach technologicznych mają większe budżety i mogą wydawać więcej na procesory graficzne. „Każdy procesor graficzny zwiększa moc” – mówi współautor badania Apoorv Khandelwal, informatyk z Brown University w Providence w stanie Rhode Island. „Podczas gdy giganci branży mogą mieć tysiące procesorów graficznych, naukowcy mogą mieć tylko kilka”.

„Rozbieżność między modelami akademickimi i przemysłowymi jest duża, ale może być znacznie mniejsza” – mówi Stella Biderman, dyrektor wykonawcza EleutherAI, instytutu badawczego non-profit zajmującego się sztuczną inteligencją w Waszyngtonie. Badania nad tą nierównością są „bardzo ważne” – dodaje.

Powolny czas oczekiwania

Aby ocenić zasoby obliczeniowe dostępne dla naukowców, Khandelwal i jego współpracownicy przeprowadzili ankietę wśród 50 naukowców z 35 instytucji. Spośród ankietowanych 66% oceniło swoje zadowolenie z mocy obliczeniowej na 3 lub mniej w skali do 5. „W ogóle nie są zadowoleni” – mówi Khandelwal.

Uniwersytety mają różne regulacje dotyczące dostępu do procesorów graficznych. Niektóre mogą mieć centralny klaster obliczeniowy współdzielony między wydziałami i studentami, gdzie badacze mogą poprosić o czas GPU. Inne instytucje mogłyby zakupić maszyny, z których mogliby korzystać bezpośrednio członkowie laboratorium.

Niektórzy naukowcy zgłaszali, że na uzyskanie dostępu do procesorów graficznych musieli czekać całymi dniami, zauważając, że czasy oczekiwania były szczególnie długie w okolicach ostatecznych terminów realizacji projektów (patrz „Wąskie gardło zasobów obliczeniowych”). Wyniki podkreślają także globalne nierówności w dostępie. Na przykład jeden z respondentów wspomniał o trudnościach ze znalezieniem procesorów graficznych na Bliskim Wschodzie. Tylko 10% respondentów stwierdziło, że ma do nich dostęp Procesory graficzne NVIDIA H100, aby mieć potężne chipy przeznaczone do badań nad sztuczną inteligencją.

Ta bariera sprawia, że proces wstępnego szkolenia – dostarczania dużych zbiorów danych do LLM – jest szczególnie trudny. „To jest tak drogie, że większość naukowców nawet nie bierze pod uwagę zajmowania się naukami ścisłymi w ramach szkolenia wstępnego” – mówi Khandelwal. On i jego współpracownicy uważają, że naukowcy oferują wyjątkową perspektywę w badaniach nad sztuczną inteligencją, a brak dostępu do mocy obliczeniowej może ograniczyć pole badawcze.

„To naprawdę ważne, aby mieć zdrowe, konkurencyjne środowisko badań akademickich dla długoterminowego wzrostu i długoterminowego rozwoju technologicznego” – mówi współautorka Ellie Pavlick, która studiuje informatykę i lingwistykę na Brown University. „Kiedy prowadzisz badania w przemyśle, istnieje wyraźna presja komercyjna, która czasami kusi cię do szybszej eksploatacji i mniejszych odkryć”.

Skuteczne metody

Naukowcy sprawdzili także, w jaki sposób naukowcy mogliby lepiej wykorzystać słabsze zasoby obliczeniowe. Obliczyli, ile czasu będzie potrzebne na wstępne przeszkolenie wielu LLM przy użyciu sprzętu o niskich zasobach – od 1 do 8 procesorów graficznych. Pomimo tych ograniczonych zasobów badaczom udało się z powodzeniem wyszkolić wiele modeli, choć trwało to dłużej i wymagało zastosowania bardziej wydajnych metod.

„W rzeczywistości możemy dłużej korzystać z procesorów graficznych, które posiadamy, dzięki czemu możemy wygładzić niektóre różnice między rozwiązaniami dostępnymi w branży” – mówi Khandelwal.

„To ekscytujące widzieć, że można wytrenować większy model, niż wiele osób by sobie wyobrażało, nawet przy ograniczonych zasobach obliczeniowych” – mówi Ji-Ung Lee, który bada modele neurojawne na Uniwersytecie Saarland w Saarbrücken w Niemczech. Dodaje, że w przyszłych pracach można będzie przyjrzeć się doświadczeniom badaczy przemysłowych w małych firmach, które również mają trudności z dostępem do zasobów obliczeniowych. „To nie jest tak, że każdy, kto ma dostęp do nieograniczonej mocy obliczeniowej, faktycznie ją otrzymuje” – mówi.

-

Khandelwal, A. i in. Przedruk w arXiv https://doi.org/10.48550/arXiv.2410.23261 (2024).

Suche

Suche

Mein Konto

Mein Konto