Division informatique de l’IA : les scientifiques n’ont pas accès à des puces puissantes pour leurs recherches

Les universitaires du monde entier sont confrontés à une puissance de calcul insuffisante pour la recherche sur l’IA. Une enquête montre de grandes différences dans l'accès aux GPU.

Division informatique de l’IA : les scientifiques n’ont pas accès à des puces puissantes pour leurs recherches

De nombreux scientifiques universitaires sont frustrés par la puissance de calcul limitée dont ils disposent pour leurs recherches dans le domaine des intelligence artificielle (IA) est disponible, comme le montre une enquête menée auprès d’universitaires de dizaines d’institutions à travers le monde.

Les résultats 1, publié le 30 octobre sur le serveur de prépublication arXiv, suggère que les universitaires n'ont pas accès aux systèmes informatiques les plus avancés. Cela pourrait affecter votre capacité à grands modèles de langage (LLM) développer et réaliser d’autres projets de recherche en IA.

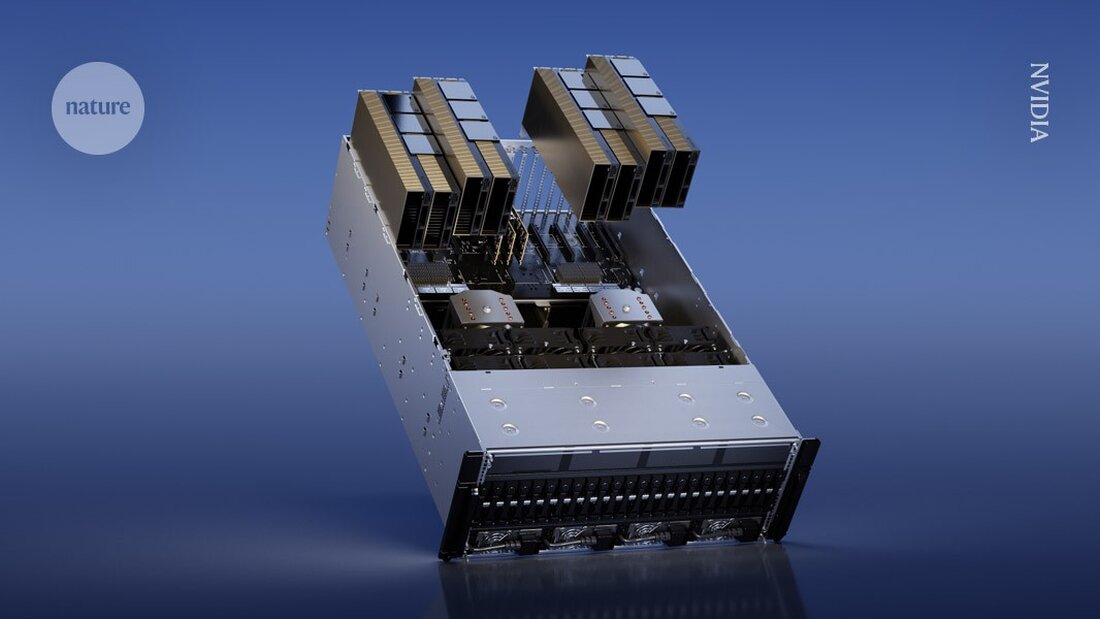

En particulier, les chercheurs universitaires n’ont parfois pas les ressources nécessaires pour être puissants Processeurs graphiques (GPU) à acheter – des puces informatiques couramment utilisées pour entraîner des modèles d’IA qui peuvent coûter plusieurs milliers de dollars. En revanche, les chercheurs des grandes entreprises technologiques disposent de budgets plus importants et peuvent dépenser davantage en GPU. "Chaque GPU ajoute plus de puissance", explique le co-auteur de l'étude Apoorv Khandelwal, informaticien à l'Université Brown de Providence, Rhode Island. « Même si ces géants de l’industrie disposent de milliers de GPU, les universitaires n’en possèdent que quelques-uns. »

« L'écart entre les modèles académiques et industriels est important, mais pourrait être beaucoup plus réduit », déclare Stella Biderman, directrice exécutive d'EleutherAI, un institut de recherche à but non lucratif sur l'IA à Washington DC. La recherche sur cette inégalité est « très importante », ajoute-t-elle.

Des délais d'attente lents

Pour évaluer les ressources informatiques disponibles pour les universitaires, Khandelwal et ses collègues ont interrogé 50 scientifiques de 35 institutions. Parmi les personnes interrogées, 66 % ont évalué leur satisfaction à l'égard de leur puissance de calcul à 3 ou moins sur une échelle de 5. « Ils ne sont pas satisfaits du tout », déclare Khandelwal.

Les universités ont des réglementations différentes pour l’accès aux GPU. Certains peuvent disposer d'un cluster de calcul central partagé entre les départements et les étudiants, où les chercheurs peuvent demander du temps GPU. D'autres institutions pourraient acheter des machines pouvant être utilisées directement par les membres du laboratoire.

Certains scientifiques ont déclaré avoir dû attendre des jours pour accéder aux GPU, notant que les temps d'attente étaient particulièrement longs aux alentours des dates limites des projets (voir « goulot d'étranglement des ressources informatiques »). Les résultats mettent également en évidence les inégalités mondiales en matière d’accès. Par exemple, un répondant a mentionné la difficulté de trouver des GPU au Moyen-Orient. Seulement 10 % des personnes interrogées ont déclaré avoir accès à Les GPU H100 de NVIDIA, pour disposer de puces puissantes conçues pour la recherche en IA.

Cet obstacle rend le processus de pré-formation – alimenter de grands ensembles de données dans les LLM – particulièrement difficile. "C'est si cher que la plupart des universitaires n'envisagent même pas de faire des sciences en pré-formation", explique Khandelwal. Lui et ses collègues estiment que les universitaires offrent une perspective unique dans la recherche sur l’IA et que le manque d’accès à la puissance de calcul pourrait limiter le domaine de la recherche.

"Il est vraiment important de disposer d'un environnement de recherche universitaire sain et compétitif pour une croissance et un développement technologique à long terme", déclare la co-auteure Ellie Pavlick, qui étudie l'informatique et la linguistique à l'Université Brown. « Lorsque vous faites de la recherche dans l’industrie, il existe des pressions commerciales évidentes qui vous incitent parfois à exploiter plus rapidement et à moins explorer. »

Des méthodes efficaces

Les chercheurs ont également examiné comment les universitaires pourraient mieux utiliser des ressources informatiques moins puissantes. Ils ont calculé combien de temps serait nécessaire pour pré-entraîner plusieurs LLM en utilisant du matériel à faibles ressources – entre 1 et 8 GPU. Malgré ces ressources limitées, les chercheurs ont réussi à former de nombreux modèles, même si cela a pris plus de temps et les a obligés à utiliser des méthodes plus efficaces.

"Nous pouvons réellement utiliser les GPU dont nous disposons plus longtemps, et ainsi atténuer certaines différences entre ceux du secteur", explique Khandelwal.

"C'est passionnant de voir qu'il est possible de former un modèle plus grand que ce que beaucoup de gens imaginent, même avec des ressources informatiques limitées", déclare Ji-Ung Lee, qui étudie les modèles neuroexplicites à l'Université de la Sarre à Sarrebruck, en Allemagne. Il ajoute que les travaux futurs pourraient examiner les expériences de chercheurs industriels travaillant dans de petites entreprises qui ont également des difficultés à accéder aux ressources informatiques. « Ce n'est pas comme si tous ceux qui ont accès à une puissance de calcul illimitée y ont accès », dit-il.

-

Khandelwal, A. et al. Préimpression sur arXiv https://doi.org/10.48550/arXiv.2410.23261 (2024).

Suche

Suche

Mein Konto

Mein Konto