AI-genererade bilder äventyrar vetenskapen-Så här vill forskare känna igen dem

Forskare kämpar mot AI-genererade falska bilder i vetenskapliga publikationer. Nya detekteringsmetoder utvecklas.

AI-genererade bilder äventyrar vetenskapen-Så här vill forskare känna igen dem

Forskare som manipulerar siffror och massproducerande falska papper Obligatorisk förläggare - Problematiska manuskript har länge varit en olägenhet i vetenskaplig litteratur. Vetenskapliga detektiv fungerar outtröttligt, för att avslöja detta fel och korrigera den vetenskapliga posten. Men deras jobb blir allt svårare eftersom ett nytt, kraftfullt verktyg för bedrägerier har dykt upp: generativ konstgjorda intelligens (Ai).

"Generativ AI utvecklas mycket snabbt," säger Jana Christopher, Bildintegritetsanalytiker på FEBS Press i Heidelberg, Tyskland. "Människor som arbetar i mitt område - bildintegritet och publiceringspolicy - blir allt mer bekymrade över de möjligheter den presenterar."

Lättheten med vilken Generativa AI Tools -texter, Bilder och data väcker rädsla för en allt mer opålitlig vetenskaplig litteratur, översvämmad med falska siffror, manuskript och slutsatser som är svåra för människor att upptäcka. Ett vapenkappet dyker upp redan eftersom integritetsspecialister, förläggare och teknikföretag arbetar flitigt för att Utveckla AI -verktyg, som snabbt kan hjälpa till att identifiera vilseledande, AI-genererade element i specialartiklar.

"Det är en skrämmande utveckling", säger Christopher. "Men det finns också smarta människor och goda strukturella förändringar som föreslås."

Experter för forskningsintegritet rapporterar att även om AI-genererad text redan är tillåtet under vissa omständigheter av många tidskrifter, kan användning av sådana verktyg för att skapa bilder eller annan data betraktas som mindre acceptabla. "Inom en snar framtid kan vi vara okej med AI-genererad text," säger Elisabeth bik, Image Forensics Specialist and Consultant i San Francisco, Kalifornien. "Men jag drar linjen när det gäller att generera data."

Bik, Christopher och andra föreslår att data, inklusive bilder, skapade med generativ AI redan används i stor utsträckning i litteraturen, och att obligatoriska förläggare använder AI -verktyg för att producera manuskript i volym (se 'Quiz: Kan du upptäcka AI -förfalskningar?').

Att identifiera AI-producerade bilder utgör en enorm utmaning: de är ofta nästan omöjliga att skilja från riktiga bilder med blotta ögat. "Vi känner att vi stöter på AI-genererade bilder varje dag," säger Christopher. "Men om du inte kan bevisa det, är det verkligen väldigt lite du kan göra."

Det finns några tydliga exempel på användningen av generativ AI i vetenskapliga bilder, som nu beryktad bild av en råtta med absurd stora könsdelar och nonsensiska etiketter, skapade med Midjourney -bildverktyget. Grafiken, som publicerades av en förbränning i februari, orsakade en storm på sociala medier och var tillbaka några dagar senare.

De flesta fall är dock inte så uppenbara. Siffror skapade med Adobe Photoshop eller liknande verktyg före tillkomsten av generativ AI - särskilt inom molekylär och cellulär biologi - innehåller ofta slående funktioner som kan erkännas av detektiv, till exempel identiska bakgrunder eller den ovanliga bristen på streck eller fläckar. AI-genererade tecken visar ofta inte sådana egenskaper. "Jag ser många papper som får mig att tro att dessa västerländska blottar inte ser riktigt ut - men det finns ingen rökpistol," säger Bik. "Allt du kan säga är att de bara ser konstiga ut och naturligtvis är det inte tillräckligt med bevis för att kontakta redaktören."

Det finns emellertid tecken på att AI-genererade tecken visas i publicerade manuskript. Texter som skrivs med hjälp av verktyg som chatgpt ökar i artiklar, tydligt med typiska chatbotfraser som författare glömmer att ta bort och distinkta ord som AI -modeller tenderar att använda. "Så vi måste anta att detta också händer för data och bilder," säger Bik.

En annan indikation på att bedrägerier använder sofistikerade avbildningsverktyg är att de flesta av de problem som utredarna för närvarande hittar i verk som är flera år gamla. "Under de senaste åren har vi sett färre och färre problem med bilder," säger Bik. "Jag tror att de flesta som fångades manipulerade bilder började skapa renare bilder."

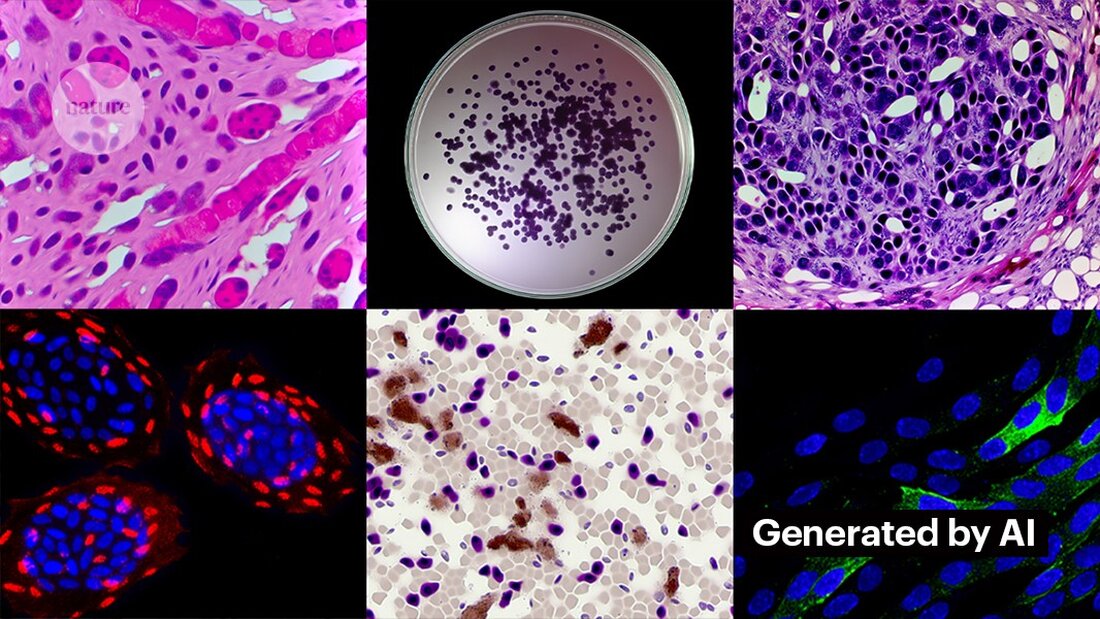

Att skapa rena bilder med generativ AI är inte svårt. Kevin Patrick, en vetenskaplig bilddetektiv som kallas Cheshire på sociala medier, har visat hur lätt det kan vara och publicerat sina resultat om X. Med hjälp av Photoshops AI -verktygsgenerativa fyllning skapade Patrick realistiska bilder - som kan visas i vetenskapliga artiklar - av tumörer, cellkulturer, västerländska blots och mer. De flesta bilder tog mindre än en minut att skapa (se "generera falsk vetenskap").

"Om jag kan göra det, kommer de som betalas för att skapa falska data också göra det också," säger Patrick. "Det finns förmodligen en hel del andra data som kan genereras med hjälp av verktyg som detta."

Vissa förläggare rapporterar att de hittade bevis på AI-genererat innehåll i publicerade studier. Detta inkluderar PLoS, som har varnat för misstänkt innehåll och hittat bevis på AI-genererad text och data i artiklar och inlägg genom interna utredningar, säger Renée Hoch, redaktör för PLOS: s publikationsetikteam i San Francisco, Kalifornien. (Hoch konstaterar att användningen av AI inte är förbjuden i PLoS -tidskrifter och att AI -policyn är baserad på författaransvar och öppna upplysningar.)

Andra verktyg kan också ge möjligheter för människor som vill skapa falskt innehåll. Förra månaden publicerade forskare en 1 Generativ AI-modell för att skapa mikroskopbilder med hög upplösning-och vissa integritetsspecialister uttryckte oro över detta arbete. "Denna teknik kan enkelt användas av människor med dåliga avsikter för att snabbt skapa hundratals eller tusentals falska bilder," säger Bik.

Yoav Shechtman från Technion-Israel Institute of Technology i Haifa, verktygets skapare, säger att verktyget är användbart för att skapa träningsdata för modeller eftersom mikroskopbilder med hög upplösning är svåra att få. Men han tillägger att det inte är användbart för att generera förfalskningar eftersom användare har liten kontroll över resultaten. Befintlig bildredigeringsprogramvara som Photoshop är mer användbar för att manipulera siffror, föreslår han.

Även om mänskliga ögon kanske inte kan Känna igen AI-genererade bilder, AI kan möjligen göra detta (se "AI -bilder är svåra att känna igen").

Utvecklarna av verktyg som Imagetwin och Proofig, som använder AI för att upptäcka integritetsproblem i vetenskapliga bilder, utvidgar sin programvara till filtrera bilder skapade av generativ AI. Eftersom sådana bilder är så svåra att känna igen skapar båda företagen sina egna databaser med generativa AI -bilder för att träna sina algoritmer.

Proofig har redan släppt en funktion i sitt verktyg för att känna igen AI-genererade mikroskopbilder. Medgrundare Dror Kolodkin-Gal i Rehovot, Israel, säger att algoritmen identifierade AI-bilderna 98% av tiden vid testning med tusentals AI-genererade och riktiga bilder från artiklar. Dror tillägger att teamet nu försöker förstå vad exakt deras algoritm upptäcker.

"Jag har stora förhoppningar på dessa verktyg," säger Christopher. Men hon konstaterar att deras resultat alltid måste utvärderas av experter som kan verifiera de problem de indikerar. Christopher har ännu inte sett några bevis för att AI -bildigenkänningsprogramvaran är tillförlitlig (Proofigs interna utvärdering har ännu inte publicerats). Dessa verktyg är "begränsade, men säkert mycket användbara för att låta oss skala våra inlämningsgranskningsinsatser", tillägger hon.

Många förläggare och forskningsinstitutioner använder det redan Bevis och Imagetwin. Till exempel använder Science Journals Proofig för att kontrollera integritetsfrågor i bilder. Enligt Meagan Phelan, kommunikationsdirektör för Science i Washington DC, har verktyget ännu inte upptäckt några AI-genererade bilder.

Springer Nature, Nature's Publisher, utvecklar sina egna text- och bilddetekteringsverktyg, kallad Geppetto och Snapshot, som flaggar oregelbundenheter som sedan utvärderas av människor. (Nature News -teamet är redaktionellt oberoende av dess utgivare.)

Publiceringsgrupper vidtar också åtgärder för att svara på AI-genererade bilder. En talesman för International Association of Scientific, Technical and Medical (STM) förlag i Oxford, Storbritannien, sa att det tog frågan "mycket allvarligt" och svarade på initiativ som Förenad2akt och STM Integrity Hub, som behandlar aktuella frågor med obligatorisk publicering och andra akademiska integritetsfrågor.

Christopher, som leder en STM -arbetsgrupp för bildförändringar och duplikationer, säger att det finns en växande medvetenhet om att det kommer att vara nödvändigt att utveckla sätt att verifiera rådata - till exempel genom att märka bilder tagna med mikroskop med osynliga vattenmärken som liknar de som används Vattenmärken i AI-genererade texter - Det kan vara rätt sätt. Detta kräver ny teknik och nya standarder för enhetstillverkare, tillägger hon.

Patrick och andra oroar sig för att förläggare inte agerar tillräckligt snabbt för att hantera hotet. "Vi är rädda för att detta bara kommer att bli en generation av problem i litteraturen som de inte tar upp förrän det är för sent," säger han.

Fortfarande är vissa optimistiska för att det AI-genererade innehållet som visas i artiklar idag kommer att upptäckas i framtiden.

"Jag har all förtroende för att tekniken kommer att förbättras till den punkt där den känner igen de uppgifter som skapas idag - eftersom detta vid någon tidpunkt kommer att betraktas som relativt grov," säger Patrick. "Bedrägerier borde inte sova bra på natten. De kan lura den nuvarande processen, men jag tror inte att de kan lura processen för alltid."

-

Saguy, A. et al. Liten meth. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto