Imaginile generate de inteligența artificială pun în pericol știința – așa vor cercetatorii să le recunoască

Cercetătorii luptă împotriva imaginilor false generate de AI în publicațiile științifice. Se dezvoltă noi metode de detectare.

Imaginile generate de inteligența artificială pun în pericol știința – așa vor cercetatorii să le recunoască

Oamenii de știință manipulează numere și produc în masă documente false Editori obligatorii – manuscrisele problematice au fost multă vreme o pacoste în literatura științifică. Detectivii științifici lucrează neobosit, pentru a dezvălui această abatere și a corecta dosarul științific. Dar munca lor devine din ce în ce mai dificilă pe măsură ce a apărut un nou instrument puternic pentru fraudatori: generativ inteligenţă artificială (AI).

„IA generativă se dezvoltă foarte repede”, spune Jana Christopher, Analist de integritate a imaginii la FEBS Press din Heidelberg, Germania. „Oamenii care lucrează în zona mea – integritatea imaginii și politicile de publicare – devin din ce în ce mai preocupați de posibilitățile pe care le prezintă.”

Ușurința cu care texte cu instrumente AI generative, imaginile și datele ridică temeri cu privire la o literatură științifică din ce în ce mai nesigură, inundată de numere false, manuscrise și concluzii greu de detectat de către oameni. O cursă a înarmărilor este deja în curs de dezvoltare, pe măsură ce specialiștii în integritate, editorii și companiile de tehnologie lucrează cu sârguință Dezvoltați instrumente AI, care poate ajuta la identificarea rapidă a elementelor înșelătoare, generate de inteligență artificială, în articolele de specialitate.

„Este o evoluție înfricoșătoare”, spune Christopher. „Dar există și oameni inteligenți și schimbări structurale bune sunt propuse.”

Experții în integritatea cercetării raportează că, deși textul generat de AI este deja permis în anumite circumstanțe de multe reviste, utilizarea unor astfel de instrumente pentru a crea imagini sau alte date poate fi considerată mai puțin acceptabilă. „În viitorul apropiat, este posibil să fim de acord cu textul generat de AI”, spune Elisabeth Bik, specialist în criminalistică imagine și consultant în San Francisco, California. „Dar trag linie atunci când vine vorba de generarea de date.”

Bik, Christopher și alții sugerează că datele, inclusiv imaginile, create cu IA generativă sunt deja utilizate pe scară largă în literatură și că editorii obligatorii folosesc instrumente AI pentru a produce manuscrise în volum (consultați „Quiz: Can You Spot AI Forgeries?”).

Identificarea imaginilor produse de AI reprezintă o provocare enormă: ele sunt adesea aproape imposibil de distins de imaginile reale cu ochiul liber. „Simțim că întâlnim în fiecare zi imagini generate de AI”, spune Christopher. „Dar dacă nu poți dovedi asta, într-adevăr poți face foarte puțin.”

Există câteva exemple clare de utilizare a IA generativă în imagini științifice, cum ar fi acum infama imagine a unui șobolan cu organele genitale absurd de mari și etichete fără sens, create cu instrumentul de imagine Midjourney. Grafica, publicată de o revistă comercială în februarie, a provocat furtună pe rețelele de socializare și a fost retras câteva zile mai târziu.

Cu toate acestea, majoritatea cazurilor nu sunt atât de evidente. Figurile create folosind Adobe Photoshop sau instrumente similare înainte de apariția IA generativă - în special în biologia moleculară și celulară - conțin adesea caracteristici izbitoare care pot fi recunoscute de detectivi, cum ar fi fundaluri identice sau lipsa neobișnuită de dungi sau pete. Caracterele generate de AI nu prezintă adesea astfel de caracteristici. „Văd o mulțime de lucrări care mă fac să cred că aceste pete Western nu par reale – dar nu există nicio armă fumegătoare”, spune Bik. „Tot ce poți spune este că arată ciudat și, desigur, nu sunt suficiente dovezi pentru a contacta editorul”.

Cu toate acestea, există semne că personajele generate de AI apar în manuscrisele publicate. Textele scrise folosind instrumente precum ChatGPT sunt în creștere în articole, evident prin expresiile tipice de chatbot pe care autorii uită să le elimine și cuvinte distinctive pe care modelele AI tind să le folosească. „Deci trebuie să presupunem că acest lucru se întâmplă și pentru date și imagini”, spune Bik.

Un alt indiciu că fraudătorii folosesc instrumente sofisticate de imagistică este faptul că majoritatea problemelor pe care anchetatorii le găsesc în prezent apar în lucrări vechi de câțiva ani. „În ultimii ani, am văzut din ce în ce mai puține probleme cu imaginile”, spune Bik. „Cred că majoritatea oamenilor care au fost prinși manipulând imagini au început să creeze imagini mai curate.”

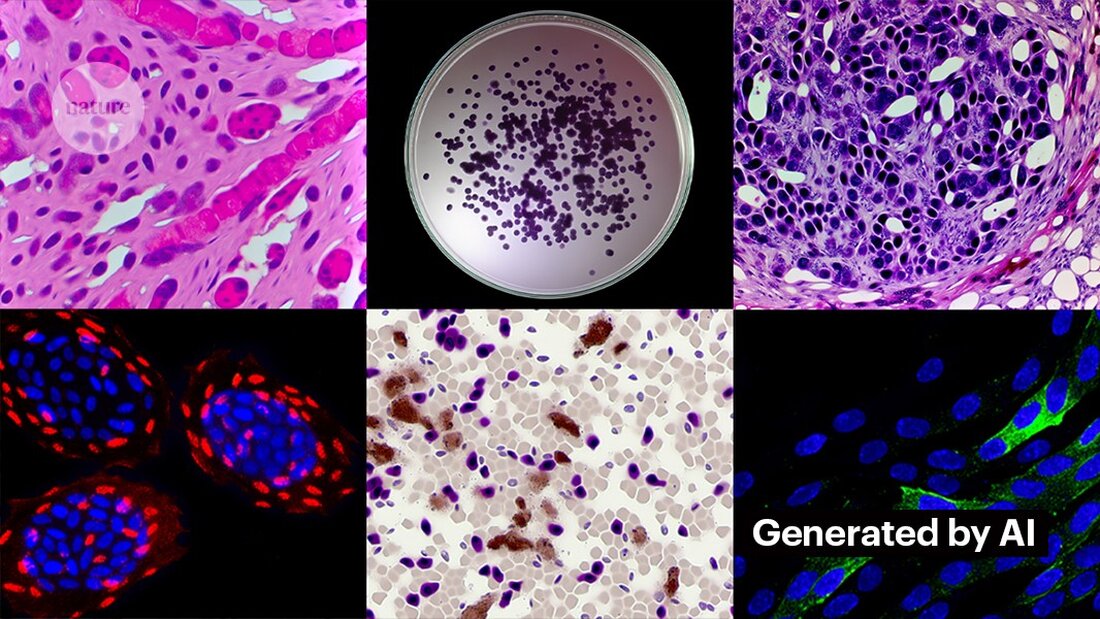

Crearea de imagini curate cu AI generativă nu este dificilă. Kevin Patrick, un detectiv de imagini științifice cunoscut sub numele de Cheshire pe rețelele sociale, a demonstrat cât de ușor poate fi și și-a publicat descoperirile pe X. Folosind instrumentul AI Generative Fill de la Photoshop, Patrick a creat imagini realiste - care ar putea apărea în lucrări științifice - cu tumori, culturi celulare, Western blot și multe altele. Majoritatea imaginilor au fost create în mai puțin de un minut (consultați „Generarea științei false”).

„Dacă pot face asta, atunci cu siguranță cei care sunt plătiți pentru a crea date false o vor face și ei”, spune Patrick. „Probabil că există o mulțime de alte date care ar putea fi generate folosind instrumente ca acesta.”

Unii editori raportează că au găsit dovezi ale conținutului generat de AI în studiile publicate. Aceasta include PLoS, care a fost alertat cu privire la conținut suspect și a găsit dovezi ale textului și datelor generate de AI în articole și trimiteri prin investigații interne, spune Renée Hoch, editor al echipei de etică a publicațiilor PLoS din San Francisco, California. (Hoch observă că utilizarea AI nu este interzisă în jurnalele PLoS și că politica AI se bazează pe responsabilitatea autorului și dezvăluiri transparente.)

Alte instrumente ar putea oferi, de asemenea, oportunități pentru persoanele care doresc să creeze conținut fals. Luna trecută, cercetătorii au publicat un 1 model AI generativ pentru a crea imagini la microscop de înaltă rezoluție – iar unii specialiști în integritate și-au exprimat îngrijorarea cu privire la această activitate. „Această tehnologie poate fi folosită cu ușurință de oameni cu intenții rele de a crea rapid sute sau mii de imagini false”, spune Bik.

Yoav Shechtman de la Institutul de Tehnologie Technion-Israel din Haifa, creatorul instrumentului, spune că instrumentul este util pentru crearea de date de antrenament pentru modele, deoarece imaginile la microscop de înaltă rezoluție sunt dificil de obținut. Dar el adaugă că nu este util pentru generarea de falsuri, deoarece utilizatorii au puțin control asupra rezultatelor. Software-ul existent de editare a imaginilor, cum ar fi Photoshop, este mai util pentru manipularea figurilor, sugerează el.

Deși ochii umani s-ar putea să nu poată Recunoașteți imaginile generate de AI, AI ar putea face acest lucru (consultați „Imaginile AI sunt greu de recunoscut”).

Dezvoltatorii de instrumente precum Imagetwin și Proofig, care folosesc AI pentru a detecta probleme de integritate în imaginile științifice, își extind software-ul pentru a filtra imaginile create de AI generativă. Deoarece astfel de imagini sunt atât de greu de recunoscut, ambele companii își creează propriile baze de date cu imagini AI generative pentru a-și antrena algoritmii.

Proofig a lansat deja o funcție în instrumentul său pentru recunoașterea imaginilor microscopului generate de AI. Cofondatorul Dror Kolodkin-Gal din Rehovot, Israel, spune că în testarea cu mii de imagini reale generate de AI din articole, algoritmul a identificat corect imaginile AI în 98% din timp și a avut o rată de fals pozitive de 0,02%. Dror adaugă că echipa încearcă acum să înțeleagă ce detectează exact algoritmul lor.

„Am mari speranțe în aceste instrumente”, spune Christopher. Totuși, ea notează că rezultatele lor trebuie întotdeauna evaluate de experți care pot verifica problemele pe care le indică. Christopher nu a văzut încă nicio dovadă că software-ul de recunoaștere a imaginii AI este de încredere (evaluarea internă a Proofig nu a fost încă publicată). Aceste instrumente sunt „limitate, dar cu siguranță foarte utile pentru a ne permite să ne extindem eforturile de revizuire a trimiterilor”, adaugă ea.

Mulți editori și instituții de cercetare îl folosesc deja Dovada şi Imagetwin. De exemplu, reviste de știință folosesc Proofig pentru a verifica problemele de integritate în imagini. Potrivit lui Meagan Phelan, director de comunicații pentru Science din Washington DC, instrumentul nu a descoperit încă nicio imagine generată de AI.

Springer Nature, editorul Nature, își dezvoltă propriile instrumente de detectare a textului și a imaginilor, numite Geppetto și SnapShot, care semnalează neregulile care sunt apoi evaluate de oameni. (Echipa de știri Nature este independentă din punct de vedere editorial de editorul său.)

Grupurile de publicare iau, de asemenea, măsuri pentru a răspunde imaginilor generate de AI. Un purtător de cuvânt al Asociației Internaționale a Editorilor Științifici, Tehnici și Medicali (STM) din Oxford, Marea Britanie, a declarat că ia problema „foarte în serios” și că răspunde la inițiative precum United2Act și STM Integrity Hub, care abordează problemele actuale cu publicarea obligatorie și alte probleme de integritate academică.

Christopher, care conduce un grup de lucru STM privind modificările și duplicarea imaginilor, spune că există o conștientizare tot mai mare că va fi necesar să se dezvolte modalități de verificare a datelor brute - de exemplu, prin etichetarea imaginilor realizate cu microscoape cu filigrane invizibile similare cu cele utilizate. Filigrane în textele generate de AI – asta ar putea fi calea corectă. Acest lucru necesită noi tehnologii și noi standarde pentru producătorii de dispozitive, adaugă ea.

Patrick și alții își fac griji că editorii nu acționează suficient de repede pentru a aborda amenințarea. „Ne temem că aceasta va fi doar o altă generație de probleme din literatura de specialitate pe care nu le abordează până nu este prea târziu”, spune el.

Cu toate acestea, unii sunt optimiști că conținutul generat de AI care apare în articolele de astăzi va fi descoperit în viitor.

„Am toată încrederea că tehnologia se va îmbunătăți până la punctul în care recunoaște datele care sunt create astăzi – pentru că la un moment dat acest lucru va fi considerat relativ grosier”, spune Patrick. "Efraudatorii nu ar trebui să doarmă bine noaptea. Ar putea păcăli procesul actual, dar nu cred că pot păcăli procesul pentru totdeauna".

-

Saguy, A. şi colab. Mic Meth. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto