Imagens geradas por IA colocam a ciência em perigo – é assim que os pesquisadores querem reconhecê-las

Os pesquisadores estão lutando contra imagens falsas geradas por IA em publicações científicas. Novos métodos de detecção estão sendo desenvolvidos.

Imagens geradas por IA colocam a ciência em perigo – é assim que os pesquisadores querem reconhecê-las

Cientistas manipulando números e produzindo documentos falsos em massa Editores obrigatórios – manuscritos problemáticos têm sido um incômodo na literatura científica. Detetives científicos trabalham incansavelmente, para expor essa irregularidade e corrigir o registro científico. Mas o seu trabalho está a tornar-se cada vez mais difícil à medida que surge uma ferramenta nova e poderosa para os fraudadores: inteligência artificial (IA).

“A IA generativa está se desenvolvendo muito rapidamente”, diz Jana Cristóvão, Analista de Integridade de Imagem na FEBS Press em Heidelberg, Alemanha. “As pessoas que trabalham na minha área – integridade de imagem e políticas de publicação – estão cada vez mais preocupadas com as possibilidades que isso apresenta.”

A facilidade com que textos de ferramentas generativas de IA, imagens e dados levantam receios de uma literatura científica cada vez mais pouco fiável, inundada de números, manuscritos e conclusões falsos que são difíceis de detetar pelos humanos. Uma corrida armamentista já está emergindo à medida que especialistas em integridade, editores e empresas de tecnologia trabalham diligentemente para Desenvolva ferramentas de IA, que pode ajudar a identificar rapidamente elementos enganosos gerados por IA em artigos especializados.

“É um desenvolvimento assustador”, diz Christopher. “Mas também há pessoas inteligentes e boas mudanças estruturais sendo propostas.”

Especialistas em integridade de pesquisa relatam que, embora o texto gerado por IA já seja permitido em determinadas circunstâncias por muitos periódicos, o uso de tais ferramentas para criar imagens ou outros dados pode ser considerado menos aceitável. “Em um futuro próximo, poderemos aceitar textos gerados por IA”, diz Elisabeth Bik, especialista em análise forense de imagens e consultor em São Francisco, Califórnia. “Mas eu estabeleço limites quando se trata de gerar dados.”

Bik, Christopher e outros sugerem que os dados, incluindo imagens, criados com IA generativa já são amplamente utilizados na literatura, e que os editores obrigatórios estão a utilizar ferramentas de IA para produzir manuscritos em volume (ver ‘Quiz: Can You Spot AI Forgeries?’).

A identificação de imagens produzidas por IA representa um enorme desafio: muitas vezes é quase impossível distingui-las de imagens reais a olho nu. “Sentimos que nos deparamos com imagens geradas por IA todos os dias”, diz Christopher. “Mas, a menos que você possa provar isso, há muito pouco que você possa fazer.”

Existem alguns exemplos claros do uso de IA generativa em imagens científicas, como o imagem agora infame de um rato com órgãos genitais absurdamente grandes e rótulos sem sentido, criados com a ferramenta de imagem Midjourney. O gráfico, publicado por uma revista especializada em fevereiro, causou uma tempestade nas redes sociais e foi retirado alguns dias depois.

No entanto, a maioria dos casos não é tão óbvia. Figuras criadas usando o Adobe Photoshop ou ferramentas similares antes do advento da IA generativa – particularmente em biologia molecular e celular – geralmente contêm características marcantes que podem ser reconhecidas pelos detetives, como fundos idênticos ou a falta incomum de listras ou manchas. Personagens gerados por IA geralmente não apresentam tais características. “Vejo muitos artigos que me fazem pensar que esses Western blots não parecem reais – mas não há prova definitiva”, diz Bik. "Tudo o que você pode dizer é que eles parecem estranhos e, claro, isso não é evidência suficiente para entrar em contato com o editor."

No entanto, há sinais de que caracteres gerados por IA estão aparecendo em manuscritos publicados. Textos escritos usando ferramentas como ChatGPT estão aumentando em artigos, evidentes por frases típicas de chatbot que os autores esquecem de remover e palavras distintas que os modelos de IA tendem a usar. “Portanto, temos que assumir que isso também acontece com dados e imagens”, diz Bik.

Outra indicação de que os fraudadores estão usando ferramentas sofisticadas de imagem é que a maioria dos problemas que os investigadores encontram atualmente aparecem em trabalhos com vários anos. “Nos últimos anos temos visto cada vez menos problemas com imagens”, diz Bik. “Acho que a maioria das pessoas que foram flagradas manipulando imagens começaram a criar imagens mais limpas.”

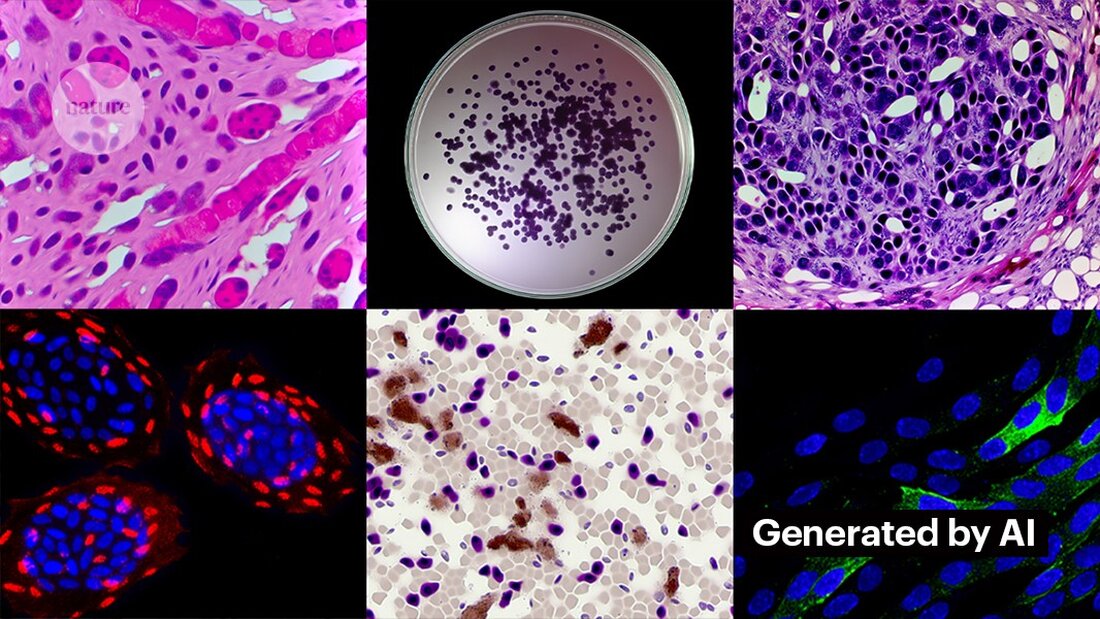

Criar imagens limpas com IA generativa não é difícil. Kevin Patrick, um detetive de imagens científicas conhecido como Cheshire nas redes sociais, demonstrou como isso pode ser fácil e publicou suas descobertas no X. Usando a ferramenta de IA do Photoshop, Generative Fill, Patrick criou imagens realistas - que poderiam aparecer em artigos científicos - de tumores, culturas de células, Western blots e muito mais. A maioria das imagens levou menos de um minuto para ser criada (veja ‘Gerando Falsa Ciência’).

“Se eu puder fazer isso, certamente aqueles que são pagos para criar dados falsos também o farão”, diz Patrick. “Provavelmente há muitos outros dados que poderiam ser gerados usando ferramentas como esta.”

Alguns editores relatam ter encontrado evidências de conteúdo gerado por IA em estudos publicados. Isso inclui a PLoS, que foi alertada sobre conteúdo suspeito e encontrou evidências de textos e dados gerados por IA em artigos e submissões por meio de investigações internas, diz Renée Hoch, editora da equipe de ética de publicação da PLoS em São Francisco, Califórnia. (Hoch observa que o uso de IA não é proibido em periódicos PLoS e que a política de IA é baseada na responsabilidade do autor e em divulgações transparentes.)

Outras ferramentas também podem oferecer oportunidades para pessoas que desejam criar conteúdo falso. No mês passado, pesquisadores publicaram um 1 modelo generativo de IA para criar imagens microscópicas de alta resolução – e alguns especialistas em integridade expressaram preocupações sobre este trabalho. “Essa tecnologia pode ser facilmente usada por pessoas mal intencionadas para criar rapidamente centenas ou milhares de imagens falsas”, diz Bik.

Yoav Shechtman, do Instituto de Tecnologia Technion – Israel em Haifa, o criador da ferramenta, diz que a ferramenta é útil para criar dados de treinamento para modelos porque é difícil obter imagens de microscópio de alta resolução. Mas acrescenta que não é útil para gerar falsificações porque os usuários têm pouco controle sobre os resultados. Os softwares de edição de imagens existentes, como o Photoshop, são mais úteis para manipular figuras, sugere ele.

Embora os olhos humanos possam não ser capazes de Reconhecer imagens geradas por IA, a IA poderia fazer isso (consulte ‘As imagens de IA são difíceis de reconhecer’).

Os desenvolvedores de ferramentas como Imagetwin e Proofig, que usam IA para detectar problemas de integridade em imagens científicas, estão expandindo seu software para filtrar imagens criadas por IA generativa. Como essas imagens são tão difíceis de reconhecer, ambas as empresas estão criando seus próprios bancos de dados de imagens generativas de IA para treinar seus algoritmos.

A Proofig já lançou um recurso em sua ferramenta para reconhecimento de imagens de microscópio geradas por IA. O cofundador Dror Kolodkin-Gal em Rehovot, Israel, diz que em testes com milhares de imagens reais e geradas por IA de artigos, o algoritmo identificou corretamente imagens de IA 98% das vezes e teve uma taxa de falsos positivos de 0,02%. Dror acrescenta que a equipe agora está tentando entender exatamente o que seu algoritmo detecta.

“Tenho grandes esperanças nessas ferramentas”, diz Christopher. Porém, ela ressalta que seus resultados devem sempre ser avaliados por especialistas que possam verificar os problemas que apontam. Christopher ainda não viu nenhuma evidência de que o software de reconhecimento de imagem de IA seja confiável (a avaliação interna do Proofig ainda não foi publicada). Essas ferramentas são “limitadas, mas certamente muito úteis para nos permitir dimensionar nossos esforços de revisão de submissões”, acrescenta ela.

Muitos editores e instituições de pesquisa já o utilizam Prova e Imagem gêmea. Por exemplo, revistas científicas usam o Proofig para verificar problemas de integridade em imagens. Segundo Meagan Phelan, diretora de comunicações da Ciência em Washington DC, a ferramenta ainda não descobriu nenhuma imagem gerada por IA.

A Springer Nature, editora da Nature, está desenvolvendo suas próprias ferramentas de detecção de texto e imagem, chamadas Geppetto e SnapShot, que sinalizam irregularidades que são então avaliadas por humanos. (A equipe de notícias da Nature é editorialmente independente de seu editor.)

Os grupos de publicação também estão tomando medidas para responder às imagens geradas por IA. Um porta-voz da Associação Internacional de Editores Científicos, Técnicos e Médicos (STM) em Oxford, Reino Unido, disse que estava levando a questão "muito a sério" e respondendo a iniciativas como United2Act e o STM Integrity Hub, que aborda questões atuais de publicação obrigatória e outras questões de integridade acadêmica.

Christopher, que lidera um grupo de trabalho STM sobre alterações e duplicações de imagens, diz que há uma consciência crescente de que será necessário desenvolver formas de verificar dados brutos - por exemplo, rotulando imagens tiradas com microscópios com marcas d'água invisíveis semelhantes às usadas Marcas d'água em textos gerados por IA – esse poderia ser o caminho certo. Isto exige novas tecnologias e novos padrões para os fabricantes de dispositivos, acrescenta ela.

Patrick e outros temem que os editores não estejam agindo com rapidez suficiente para enfrentar a ameaça. “Tememos que esta seja apenas mais uma geração de problemas na literatura que não serão abordados até que seja tarde demais”, diz ele.

Ainda assim, alguns estão otimistas de que o conteúdo gerado pela IA que aparece hoje nos artigos será descoberto no futuro.

“Tenho plena confiança de que a tecnologia irá melhorar ao ponto de reconhecer os dados que estão sendo criados hoje – porque em algum momento isso será considerado relativamente grosseiro”, diz Patrick. “Os fraudadores não deveriam dormir bem à noite. Eles poderiam enganar o processo atual, mas não acho que possam enganar o processo para sempre.”

-

Saguy, A. et al. Metanfetamina pequena. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto