Obrazy generowane przez sztuczną inteligencję zagrażają nauce – tak naukowcy chcą je rozpoznać

Naukowcy walczą z fałszywymi obrazami generowanymi przez sztuczną inteligencję w publikacjach naukowych. Opracowywane są nowe metody wykrywania.

Obrazy generowane przez sztuczną inteligencję zagrażają nauce – tak naukowcy chcą je rozpoznać

Naukowcy manipulują liczbami i masowo produkują fałszywe dokumenty Obowiązkowi wydawcy – problematyczne rękopisy od dawna stanowią utrapienie w literaturze naukowej. Detektywi naukowi pracują niestrudzenie, aby zdemaskować to niewłaściwe postępowanie i skorygować doniesienia naukowe. Jednak ich praca staje się coraz trudniejsza w miarę pojawiania się nowego, potężnego narzędzia dla oszustów: generatywnego sztuczna inteligencja (AI).

„Generatywna sztuczna inteligencja rozwija się bardzo szybko” – mówi Jana Krzysztofa, analityk ds. integralności obrazu w FEBS Press w Heidelbergu, Niemcy. „Osoby pracujące w mojej branży – uczciwość wizerunku i polityka wydawnicza – są coraz bardziej zaniepokojone możliwościami, jakie się z tym wiążą”.

Łatwość, z jaką teksty dotyczące narzędzi generatywnych AI, obrazy i dane budzą strach przed coraz bardziej nierzetelną literaturą naukową, zalaną fałszywymi liczbami, rękopisami i wnioskami, które są trudne do wykrycia przez człowieka. Wyścig zbrojeń już się rozpoczyna, nad czym pilnie pracują specjaliści ds. uczciwości, wydawcy i firmy technologiczne Rozwijaj narzędzia AI, które mogą pomóc szybko zidentyfikować w specjalistycznych artykułach zwodnicze elementy generowane przez sztuczną inteligencję.

„To przerażający rozwój sytuacji” – mówi Christopher. „Ale są też mądrzy ludzie i proponowane są dobre zmiany strukturalne”.

Eksperci ds. rzetelności badawczej podają, że chociaż wiele czasopism zezwala już w pewnych okolicznościach na tekst generowany przez sztuczną inteligencję, używanie takich narzędzi do tworzenia obrazów lub innych danych może zostać uznane za mniej akceptowalne. „W najbliższej przyszłości być może będziemy w stanie zaakceptować tekst generowany przez sztuczną inteligencję” – mówi Elżbieta Bik, specjalista i konsultant z zakresu kryminalistyki obrazu w San Francisco w Kalifornii. „Ale wyznaczam granicę, jeśli chodzi o generowanie danych”.

Bik, Christopher i inni sugerują, że dane, w tym obrazy, utworzone za pomocą generatywnej sztucznej inteligencji są już szeroko stosowane w literaturze i że wydawcy obowiązkowi korzystają z narzędzi sztucznej inteligencji do tworzenia masowych manuskryptów (zobacz „Quiz: Czy potrafisz dostrzec fałszerstwa AI?”).

Identyfikacja obrazów wytworzonych przez sztuczną inteligencję stanowi ogromne wyzwanie: często prawie niemożliwe jest odróżnienie ich od prawdziwych obrazów gołym okiem. „Mamy wrażenie, że codziennie natrafiamy na obrazy generowane przez sztuczną inteligencję” – mówi Christopher. „Ale jeśli nie możesz tego udowodnić, naprawdę niewiele możesz zrobić”.

Istnieje kilka wyraźnych przykładów zastosowania generatywnej sztucznej inteligencji w obrazach naukowych, takich jak obecnie niesławny wizerunek szczura z absurdalnie dużymi genitaliami i bezsensowne etykiety utworzone za pomocą narzędzia obrazu Midjourney. Grafika, opublikowana w lutym przez branżowy magazyn, wywołała burzę w mediach społecznościowych i tak też się stało wycofany kilka dni później.

Jednak większość przypadków nie jest tak oczywista. Figurki utworzone przy użyciu programu Adobe Photoshop lub podobnych narzędzi przed pojawieniem się generatywnej sztucznej inteligencji – szczególnie w biologii molekularnej i komórkowej – często zawierają uderzające cechy, które mogą zostać rozpoznane przez detektywów, takie jak identyczne tło lub niezwykły brak smug lub plam. Postacie generowane przez sztuczną inteligencję często nie wykazują takich cech. „Widzę wiele gazet, które sprawiają, że myślę, że te Western blot nie wyglądają realnie, ale nie ma co ukrywać” – mówi Bik. „Możesz tylko powiedzieć, że wyglądają po prostu dziwnie, a to oczywiście nie jest wystarczający dowód, aby skontaktować się z redaktorem”.

Istnieją jednak oznaki, że w opublikowanych rękopisach pojawiają się znaki wygenerowane przez sztuczną inteligencję. W artykułach pojawia się coraz więcej tekstów napisanych przy użyciu narzędzi takich jak ChatGPT, czego dowodem są typowe frazy chatbota, o których autorzy zapominają usunąć, oraz charakterystyczne słowa, których zwykle używają modele AI. „Musimy więc założyć, że dzieje się to również w przypadku danych i obrazów” – mówi Bik.

Inną oznaką tego, że oszuści korzystają z wyrafinowanych narzędzi do obrazowania, jest fakt, że większość problemów wykrywanych obecnie przez śledczych pojawia się w pracach sprzed kilku lat. „W ostatnich latach obserwujemy coraz mniej problemów z obrazami” – mówi Bik. „Myślę, że większość osób przyłapanych na manipulowaniu obrazami zaczęła tworzyć czystsze obrazy”.

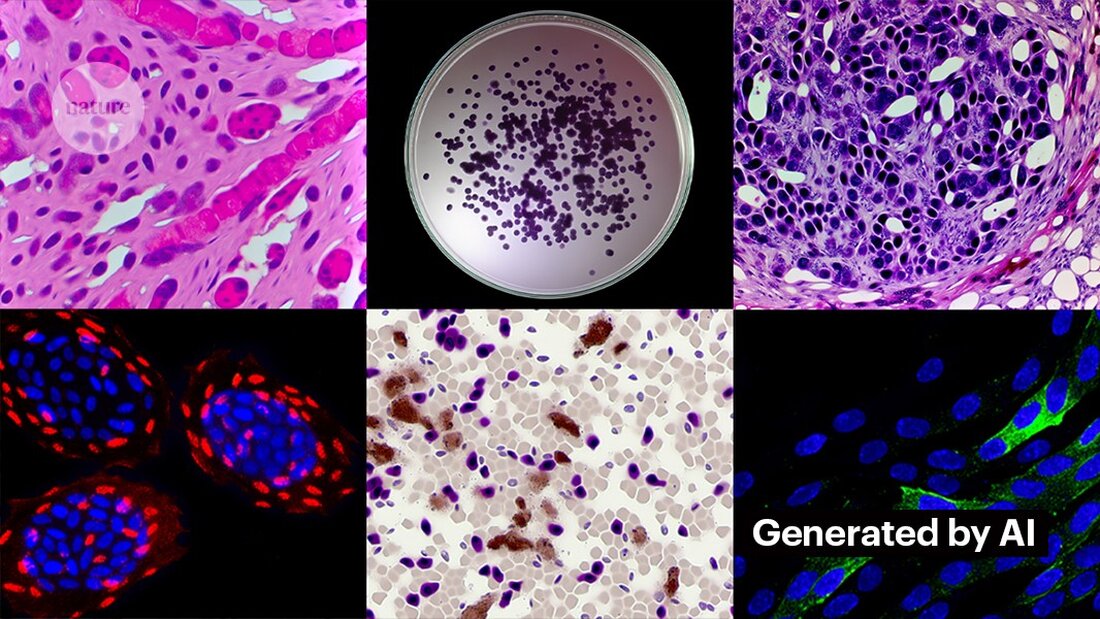

Tworzenie czystych obrazów za pomocą generatywnej sztucznej inteligencji nie jest trudne. Kevin Patrick, naukowy detektyw zajmujący się obrazami znany w mediach społecznościowych jako Cheshire, pokazał, jakie to może być proste, i opublikował swoje odkrycia w X. Używając narzędzia AI Generative Fill w Photoshopie, Patrick stworzył realistyczne obrazy – które mogłyby pojawić się w artykułach naukowych – nowotworów, hodowli komórkowych, Western blot i nie tylko. Tworzenie większości zdjęć trwało mniej niż minutę (patrz „Generowanie fałszywej nauki”).

„Jeśli mi się to uda, z pewnością zrobią to także ci, którym płacono za tworzenie fałszywych danych” – mówi Patrick. „Prawdopodobnie istnieje wiele innych danych, które można wygenerować za pomocą takich narzędzi”.

Niektórzy wydawcy zgłaszają, że w opublikowanych badaniach znaleźli dowody na istnienie treści generowanych przez sztuczną inteligencję. Obejmuje to PLoS, które zostało powiadomione o podejrzanych treściach i w wyniku wewnętrznych dochodzeń znalazło dowody na obecność tekstu i danych wygenerowanych przez sztuczną inteligencję w artykułach i zgłoszeniach, mówi Renée Hoch, redaktorka zespołu ds. etyki publikacji PLoS w San Francisco w Kalifornii. (Hoch zauważa, że wykorzystanie sztucznej inteligencji nie jest zabronione w czasopismach PLoS i że polityka dotycząca sztucznej inteligencji opiera się na odpowiedzialności autora i przejrzystym ujawnianiu informacji.)

Inne narzędzia mogą również zapewnić możliwości osobom chcącym tworzyć fałszywe treści. W zeszłym miesiącu badacze opublikowali: 1 generatywnego modelu sztucznej inteligencji do tworzenia obrazów mikroskopowych o wysokiej rozdzielczości – a niektórzy specjaliści ds. uczciwości wyrazili obawy dotyczące tej pracy. „Ludzie o złych intencjach mogą z łatwością wykorzystać tę technologię do szybkiego stworzenia setek lub tysięcy fałszywych obrazów” – mówi Bik.

Twórca narzędzia Yoav Shechtman z Technion–Israel Institute of Technology w Hajfie twierdzi, że narzędzie jest przydatne do tworzenia danych szkoleniowych dla modeli, ponieważ uzyskanie obrazów mikroskopowych o wysokiej rozdzielczości jest trudne. Dodaje jednak, że nie jest to przydatne do generowania podróbek, ponieważ użytkownicy mają niewielką kontrolę nad wynikami. Sugeruje, że istniejące oprogramowanie do edycji obrazów, takie jak Photoshop, jest bardziej przydatne do manipulowania figurami.

Chociaż ludzkie oczy mogą nie być w stanie Rozpoznawaj obrazy wygenerowane przez sztuczną inteligencję, sztuczna inteligencja prawdopodobnie mogłaby to zrobić (zobacz „Obrazy AI są trudne do rozpoznania”).

Twórcy narzędzi takich jak Imagetwin i Proofig, które wykorzystują sztuczną inteligencję do wykrywania problemów z integralnością obrazów naukowych, rozszerzają swoje oprogramowanie o filtrowanie obrazów generatywnych AI. Ponieważ takie obrazy są tak trudne do rozpoznania, obie firmy tworzą własne bazy danych zawierające obrazy generatywnej sztucznej inteligencji w celu szkolenia swoich algorytmów.

Proofig udostępnił już w swoim narzędziu funkcję rozpoznawania obrazów mikroskopowych generowanych przez sztuczną inteligencję. Współzałożyciel Dror Kolodkin-Gal z Rehovot w Izraelu twierdzi, że podczas testów obejmujących tysiące rzeczywistych i generowanych przez sztuczną inteligencję obrazów z artykułów algorytm poprawnie zidentyfikował obrazy AI w 98% przypadków, a odsetek wyników fałszywie dodatnich wynosił 0,02%. Dror dodaje, że zespół próbuje teraz zrozumieć, co dokładnie wykrywa ich algorytm.

„Wiążę duże nadzieje z tymi narzędziami” – mówi Christopher. Zaznacza jednak, że ich wyniki zawsze muszą być oceniane przez ekspertów, którzy potrafią zweryfikować wskazane przez nich problemy. Christopher nie widział jeszcze żadnych dowodów na to, że oprogramowanie do rozpoznawania obrazów AI jest niezawodne (wewnętrzna ocena Proofig nie została jeszcze opublikowana). Narzędzia te są „ograniczone, ale z pewnością bardzo przydatne, ponieważ pozwalają nam skalować wysiłki związane z recenzowaniem zgłoszeń” – dodaje.

Korzysta z niego już wielu wydawców i instytucji badawczych Dowód I Obraz bliźniaczy. Na przykład czasopisma naukowe korzystają z narzędzia Proofig do sprawdzania problemów z integralnością obrazów. Według Meagan Phelan, dyrektor ds. komunikacji w dziale nauki w Waszyngtonie, narzędzie nie odkryło jeszcze żadnych obrazów wygenerowanych przez sztuczną inteligencję.

Springer Nature, wydawca Nature, opracowuje własne narzędzia do wykrywania tekstu i obrazu, zwane Geppetto i SnapShot, które wykrywają nieprawidłowości, które są następnie oceniane przez ludzi. (Zespół informacyjny Nature jest redakcyjnie niezależny od wydawcy.)

Grupy wydawnicze również podejmują kroki, aby reagować na obrazy generowane przez sztuczną inteligencję. Rzecznik Międzynarodowego Stowarzyszenia Wydawców Naukowych, Technicznych i Medycznych (STM) w Oksfordzie w Wielkiej Brytanii powiedział, że podchodzi ono do tej kwestii „bardzo poważnie” i reaguje na inicjatywy takie jak United2Act oraz STM Integrity Hub, które zajmuje się bieżącymi problemami związanymi z obowiązkowymi publikacjami i innymi kwestiami związanymi z uczciwością akademicką.

Christopher, który kieruje grupą roboczą STM ds. zmian i powielania obrazów, twierdzi, że rośnie świadomość konieczności opracowania sposobów weryfikacji surowych danych – na przykład poprzez oznaczanie zdjęć wykonanych za pomocą mikroskopów niewidocznymi znakami wodnymi podobnymi do tych używanych Znaki wodne w tekstach generowanych przez sztuczną inteligencję – to może być właściwa droga. Wymaga to nowych technologii i nowych standardów dla producentów urządzeń – dodaje.

Patrick i inni martwią się, że wydawcy nie działają wystarczająco szybko, aby zaradzić zagrożeniu. „Obawiamy się, że będzie to po prostu kolejna generacja problemów w literaturze, którymi zajmie się dopiero, gdy będzie za późno” – mówi.

Mimo to niektórzy są optymistami, że treści generowane przez sztuczną inteligencję pojawiające się obecnie w artykułach zostaną odkryte w przyszłości.

„Mam całkowitą pewność, że technologia udoskonali się do tego stopnia, że będzie rozpoznawać dane tworzone obecnie, ponieważ w pewnym momencie będą one uważane za stosunkowo ogólne” – mówi Patrick. „Oszuści nie powinni spać spokojnie. Mogliby oszukać bieżący proces, ale nie sądzę, że uda im się oszukać proces w nieskończoność”.

-

Saguy, A. i in. Mała met. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto