Slike generirane umjetnom inteligencijom ugrožavaju znanost – istraživači ih tako žele prepoznati

Istraživači se bore protiv lažnih slika koje stvara umjetna inteligencija u znanstvenim publikacijama. Razvijaju se nove metode detekcije.

Slike generirane umjetnom inteligencijom ugrožavaju znanost – istraživači ih tako žele prepoznati

Znanstvenici manipuliraju brojevima i masovno proizvode lažne papire Obavezni izdavači – problematični rukopisi dugo su bili smetnja u znanstvenoj literaturi. Znanstveni detektivi neumorno rade, kako bismo razotkrili ovo zlodjelo i ispravili znanstvene zapise. No njihov posao postaje sve teži jer se pojavio novi, moćan alat za prevarante: generative umjetna inteligencija (AI).

"Generativna umjetna inteligencija se razvija vrlo brzo", kaže Jana Christopher, analitičar integriteta slike u FEBS Pressu u Heidelbergu, Njemačka. "Ljudi koji rade u mom području - integritet slike i politika objavljivanja - postaju sve zabrinutiji zbog mogućnosti koje to predstavlja."

Lakoća s kojom tekstovi generativnih AI alata, slika i podataka izaziva strah od sve nepouzdanije znanstvene literature, preplavljene lažnim brojevima, rukopisima i zaključcima koje je ljudima teško otkriti. Već se pojavljuje utrka u naoružanju jer stručnjaci za integritet, izdavači i tehnološke tvrtke marljivo rade na Razviti AI alate, koji može pomoći u brzom prepoznavanju obmanjujućih elemenata koje je generirala umjetna inteligencija u stručnim člancima.

"To je zastrašujući razvoj", kaže Christopher. "Ali ima i pametnih ljudi i predlažu se dobre strukturne promjene."

Stručnjaci za integritet istraživanja izvješćuju da iako je tekst generiran umjetnom inteligencijom već dopušten pod određenim okolnostima u mnogim časopisima, korištenje takvih alata za stvaranje slika ili drugih podataka može se smatrati manje prihvatljivim. "U bliskoj budućnosti možda ćemo biti u redu s tekstom generiranim umjetnom inteligencijom", kaže Elisabeth Bik, stručnjak za slikovnu forenziku i konzultant u San Franciscu, Kalifornija. "Ali povlačim crtu kada je u pitanju generiranje podataka."

Bik, Christopher i drugi sugeriraju da se podaci, uključujući slike, stvorene generativnom umjetnom inteligencijom, već naširoko koriste u literaturi, te da obvezni izdavači koriste alate umjetne inteligencije za proizvodnju velikih količina rukopisa (pogledajte „Kviz: Možete li uočiti krivotvorine umjetnom inteligencijom?“).

Identificiranje slika proizvedenih umjetnom inteligencijom predstavlja golem izazov: često ih je gotovo nemoguće razlikovati od stvarnih slika golim okom. "Osjećamo se kao da svaki dan nailazimo na slike generirane umjetnom inteligencijom", kaže Christopher. "Ali osim ako to ne možete dokazati, možete učiniti jako malo."

Postoje neki jasni primjeri upotrebe generativne umjetne inteligencije u znanstvenim slikama, poput sada zloglasna slika štakora s apsurdno velikim genitalijama i besmislene oznake, stvorene alatom za slike Midjourney. Grafika koju je u veljači objavio stručni časopis izazvala je buru na društvenim mrežama i bila povučen nekoliko dana kasnije.

Međutim, većina slučajeva nije tako očita. Slike stvorene pomoću programa Adobe Photoshop ili sličnih alata prije pojave generativne umjetne inteligencije - osobito u molekularnoj i staničnoj biologiji - često sadrže upečatljive značajke koje detektivi mogu prepoznati, poput identične pozadine ili neobičnog nedostatka pruga ili mrlja. Likovi generirani umjetnom inteligencijom često ne pokazuju takve karakteristike. “Vidim puno radova koji me navode na pomisao da ovi Western blotovi ne izgledaju stvarno - ali tu nema sumnje”, kaže Bik. Sve što možete reći je da samo izgledaju čudno, a to naravno nije dovoljan dokaz da kontaktirate urednika.

Međutim, postoje znakovi da se znakovi generirani umjetnom inteligencijom pojavljuju u objavljenim rukopisima. Tekstovi napisani pomoću alata poput ChatGPT-a sve su veći u člancima, što je vidljivo po tipičnim frazama chatbota koje autori zaboravljaju ukloniti i karakterističnim riječima koje AI modeli obično koriste. "Dakle, moramo pretpostaviti da se to također događa za podatke i slike", kaže Bik.

Još jedan pokazatelj da se prevaranti koriste sofisticiranim alatima za obradu slika jest da se većina problema koje istražitelji trenutačno nalaze pojavljuju u radovima starim nekoliko godina. "Posljednjih godina viđamo sve manje problema sa slikama", kaže Bik. "Mislim da je većina ljudi koji su uhvaćeni u manipuliranju slikama počela stvarati čistije slike."

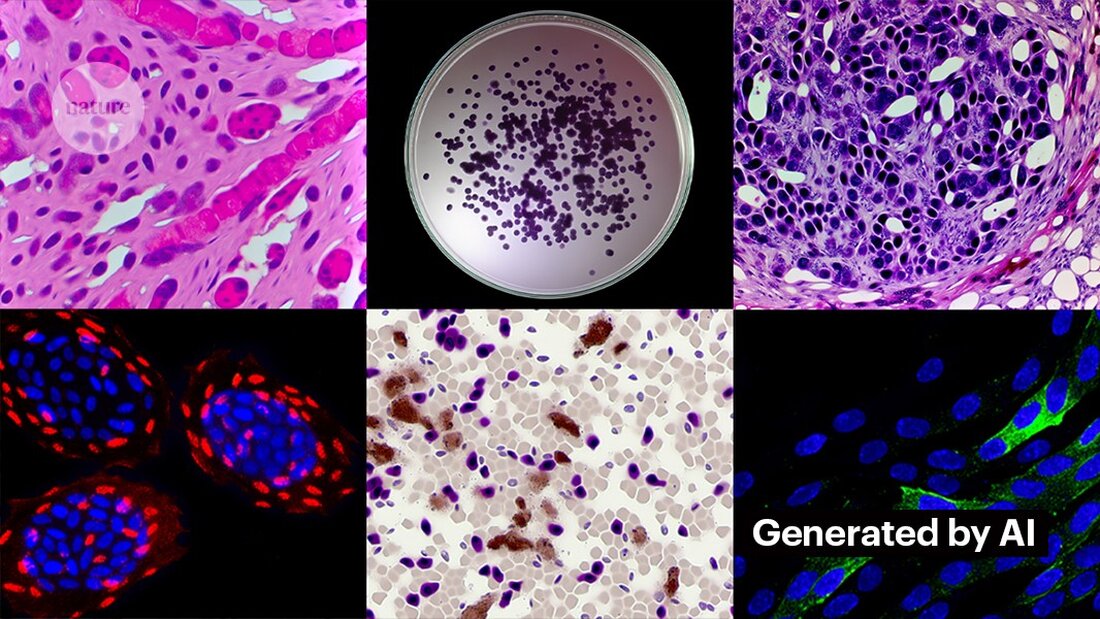

Stvaranje čistih slika s generativnom umjetnom inteligencijom nije teško. Kevin Patrick, detektiv znanstvenih slika poznat kao Cheshire na društvenim mrežama, pokazao je koliko to može biti lako i objavio svoja otkrića na X. Koristeći Photoshopov AI alat Generative Fill, Patrick je stvorio realistične slike - koje bi se mogle pojaviti u znanstvenim radovima - tumora, staničnih kultura, Western blotova i više. Za izradu većine slika bilo je potrebno manje od minute (pogledajte 'Stvaranje lažne znanosti').

"Ako ja to mogu učiniti, onda će to sigurno učiniti i oni koji su plaćeni da stvaraju lažne podatke", kaže Patrick. "Vjerojatno postoji puno drugih podataka koji bi se mogli generirati korištenjem ovakvih alata."

Neki izdavači izvješćuju da su u objavljenim studijama pronašli dokaze o sadržaju generiranom umjetnom inteligencijom. To uključuje PLoS, koji je upozoren na sumnjiv sadržaj i pronašao je dokaze o tekstu i podacima generiranim umjetnom inteligencijom u člancima i podnescima kroz interne istrage, kaže Renée Hoch, urednica PLoS-ova tima za etiku objavljivanja u San Franciscu, Kalifornija. (Hoch napominje da upotreba umjetne inteligencije nije zabranjena u PLoS časopisima i da se politika umjetne inteligencije temelji na odgovornosti autora i transparentnim otkrivanjima.)

Drugi alati također bi mogli pružiti prilike ljudima koji žele stvarati lažni sadržaj. Prošli mjesec istraživači su objavili a 1 generativni AI model za stvaranje mikroskopskih slika visoke razlučivosti – a neki stručnjaci za integritet izrazili su zabrinutost zbog ovog rada. "Ovu tehnologiju lako mogu koristiti ljudi s lošim namjerama za brzo stvaranje stotina ili tisuća lažnih slika", kaže Bik.

Yoav Shechtman s Technion–Israel Institute of Technology u Haifi, tvorac alata, kaže da je alat koristan za stvaranje podataka za obuku za modele jer je mikroskopske slike visoke rezolucije teško dobiti. Ali dodaje da to nije korisno za generiranje krivotvorina jer korisnici imaju malo kontrole nad rezultatima. Postojeći softver za uređivanje slika kao što je Photoshop korisniji je za manipuliranje brojkama, predlaže on.

Iako ljudske oči to možda neće moći Prepoznajte slike generirane umjetnom inteligencijom, umjetna inteligencija bi to mogla učiniti (pogledajte 'Teško je prepoznati AI slike').

Razvojni programeri alata kao što su Imagetwin i Proofig, koji koriste umjetnu inteligenciju za otkrivanje problema s integritetom znanstvenih slika, proširuju svoj softver za filtriranje slika stvorenih generativnom umjetnom inteligencijom. Budući da je takve slike tako teško prepoznati, obje tvrtke stvaraju vlastite baze podataka generativnih AI slika za treniranje svojih algoritama.

Proofig je već objavio značajku u svom alatu za prepoznavanje mikroskopskih slika generiranih umjetnom inteligencijom. Suosnivač Dror Kolodkin-Gal u Rehovotu, Izrael, kaže da je u testiranju s tisućama AI generiranih i stvarnih slika iz članaka, algoritam ispravno identificirao AI slike u 98% slučajeva i imao lažno pozitivnu stopu od 0,02%. Dror dodaje da tim sada pokušava razumjeti što točno njihov algoritam otkriva.

"Polažem velike nade u ove alate", kaže Christopher. No, napominje da njihove rezultate uvijek moraju evaluirati stručnjaci koji mogu provjeriti probleme na koje ukazuju. Christopher još nije vidio nikakve dokaze da je AI softver za prepoznavanje slika pouzdan (Proofigova interna procjena još nije objavljena). Ti su alati "ograničeni, ali svakako vrlo korisni jer nam omogućuju da povećamo napore pregleda podnesaka", dodaje ona.

Mnogi izdavači i istraživačke institucije već ga koriste Dokaz i Imagetwin. Na primjer, znanstveni časopisi koriste Proofig za provjeru problema s integritetom slika. Prema Meagan Phelan, direktorici komunikacija za Science u Washingtonu DC, alat još nije otkrio nijednu sliku generiranu umjetnom inteligencijom.

Springer Nature, izdavač Nature-a, razvija vlastite alate za detekciju teksta i slika, nazvane Geppetto i SnapShot, koji označavaju nepravilnosti koje zatim procjenjuju ljudi. (Tim vijesti Nature urednički je neovisan o svom izdavaču.)

Izdavačke grupe također poduzimaju korake kako bi odgovorile na slike generirane umjetnom inteligencijom. Glasnogovornik Međunarodne udruge znanstvenih, tehničkih i medicinskih izdavača (STM) u Oxfordu, Ujedinjeno Kraljevstvo, rekao je da ovo pitanje shvaća "vrlo ozbiljno" i da odgovara na inicijative poput United2Act i STM Integrity Hub, koji se bavi aktualnim problemima s obveznim objavljivanjem i drugim pitanjima akademskog integriteta.

Christopher, koji vodi STM radnu skupinu za izmjene i dupliciranje slika, kaže da raste svijest da će biti potrebno razviti načine za provjeru sirovih podataka - na primjer, označavanjem slika snimljenih mikroskopima nevidljivim vodenim žigovima sličnim onima koji se koriste Vodeni žigovi u tekstovima generiranim umjetnom inteligencijom – to bi mogao biti pravi put. To zahtijeva nove tehnologije i nove standarde za proizvođače uređaja, dodaje ona.

Patrick i drugi zabrinuti su da izdavači ne djeluju dovoljno brzo kako bi riješili prijetnju. "Bojimo se da će ovo biti samo još jedna generacija problema u literaturi kojima se ne pozabave dok ne bude prekasno", kaže on.

Ipak, neki su optimistični da će sadržaj generiran umjetnom inteligencijom koji se danas pojavljuje u člancima biti otkriven u budućnosti.

"Sve sam uvjeren da će se tehnologija poboljšati do točke u kojoj će prepoznavati podatke koji se danas stvaraju - jer će se to u jednom trenutku smatrati relativno grubim", kaže Patrick. "Prevaranti ne bi trebali dobro spavati noću. Mogli bi prevariti trenutni proces, ali ne mislim da mogu zavaravati proces zauvijek."

-

Saguy, A. i sur. Mali Meth. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto