Les images générées par l’IA mettent la science en danger – c’est ainsi que les chercheurs veulent les reconnaître

Les chercheurs luttent contre les fausses images générées par l’IA dans les publications scientifiques. De nouvelles méthodes de détection se développent.

Les images générées par l’IA mettent la science en danger – c’est ainsi que les chercheurs veulent les reconnaître

Des scientifiques manipulent les chiffres et produisent en masse de faux articles Editeurs obligatoires – les manuscrits problématiques sont depuis longtemps une nuisance dans la littérature scientifique. Les détectives scientifiques travaillent sans relâche, pour dénoncer cet acte répréhensible et corriger le dossier scientifique. Mais leur travail devient de plus en plus difficile à mesure qu'un nouvel outil puissant pour les fraudeurs est apparu : intelligence artificielle (IA).

"L'IA générative se développe très rapidement", déclare Jana Christophe, analyste de l'intégrité de l'image chez FEBS Press à Heidelberg, en Allemagne. « Les gens qui travaillent dans mon domaine – intégrité de l’image et politiques de publication – sont de plus en plus préoccupés par les possibilités que cela offre. »

La facilité avec laquelle textes d'outils d'IA génératifs, images et données font craindre une littérature scientifique de moins en moins fiable, inondée de faux chiffres, manuscrits et conclusions difficiles à détecter pour l’homme. Une course aux armements est déjà en train d’émerger alors que les spécialistes de l’intégrité, les éditeurs et les entreprises technologiques travaillent avec diligence pour Développer des outils d'IA, qui peut aider à identifier rapidement les éléments trompeurs générés par l’IA dans les articles spécialisés.

«C’est une évolution effrayante», déclare Christopher. "Mais il y a aussi des gens intelligents et de bons changements structurels qui sont proposés."

Les experts en intégrité de la recherche rapportent que même si le texte généré par l’IA est déjà autorisé dans certaines circonstances par de nombreuses revues, l’utilisation de tels outils pour créer des images ou d’autres données peut être considérée comme moins acceptable. "Dans un avenir proche, nous pourrions être d'accord avec le texte généré par l'IA", déclare Elisabeth Bik, spécialiste de la criminalistique de l'image et consultant à San Francisco, Californie. "Mais je fixe une limite lorsqu'il s'agit de générer des données."

Bik, Christopher et d’autres suggèrent que les données, y compris les images, créées avec l’IA générative sont déjà largement utilisées dans la littérature et que les éditeurs obligatoires utilisent des outils d’IA pour produire des manuscrits en volume (voir « Quiz : pouvez-vous repérer les contrefaçons d’IA ? »).

L’identification des images produites par l’IA représente un énorme défi : il est souvent presque impossible de les distinguer des images réelles à l’œil nu. « Nous avons l’impression de tomber quotidiennement sur des images générées par l’IA », explique Christopher. "Mais à moins que vous ne puissiez le prouver, vous ne pouvez vraiment pas faire grand-chose."

Il existe des exemples clairs d’utilisation de l’IA générative dans les images scientifiques, comme le image désormais tristement célèbre d'un rat aux organes génitaux absurdement grands et des étiquettes absurdes, créées avec l'outil d'image Midjourney. Le graphique, publié par un magazine spécialisé en février, a provoqué une tempête sur les réseaux sociaux et a été retiré quelques jours plus tard.

Cependant, la plupart des cas ne sont pas aussi évidents. Les figures créées à l'aide d'Adobe Photoshop ou d'outils similaires avant l'avènement de l'IA générative - en particulier en biologie moléculaire et cellulaire - contiennent souvent des caractéristiques frappantes qui peuvent être reconnues par les détectives, comme des arrière-plans identiques ou l'absence inhabituelle de stries ou de taches. Les personnages générés par l’IA ne présentent souvent pas de telles caractéristiques. "Je vois beaucoup d'articles qui me font penser que ces Western blots ne semblent pas réels - mais il n'y a pas de preuve irréfutable", déclare Bik. "Tout ce que vous pouvez dire, c'est qu'ils ont l'air étranges, et bien sûr, ce n'est pas une preuve suffisante pour contacter l'éditeur."

Cependant, certains signes indiquent que des personnages générés par l’IA apparaissent dans les manuscrits publiés. Les textes écrits à l'aide d'outils tels que ChatGPT sont de plus en plus nombreux dans les articles, comme en témoignent les phrases typiques des chatbots que les auteurs oublient de supprimer et les mots distinctifs que les modèles d'IA ont tendance à utiliser. «Nous devons donc supposer que cela se produit également pour les données et les images», explique Bik.

Une autre indication que les fraudeurs utilisent des outils d'imagerie sophistiqués est que la plupart des problèmes que les enquêteurs découvrent actuellement apparaissent dans des œuvres vieilles de plusieurs années. «Ces dernières années, nous avons constaté de moins en moins de problèmes avec les images», explique Bik. "Je pense que la plupart des gens surpris en train de manipuler des images ont commencé à créer des images plus nettes."

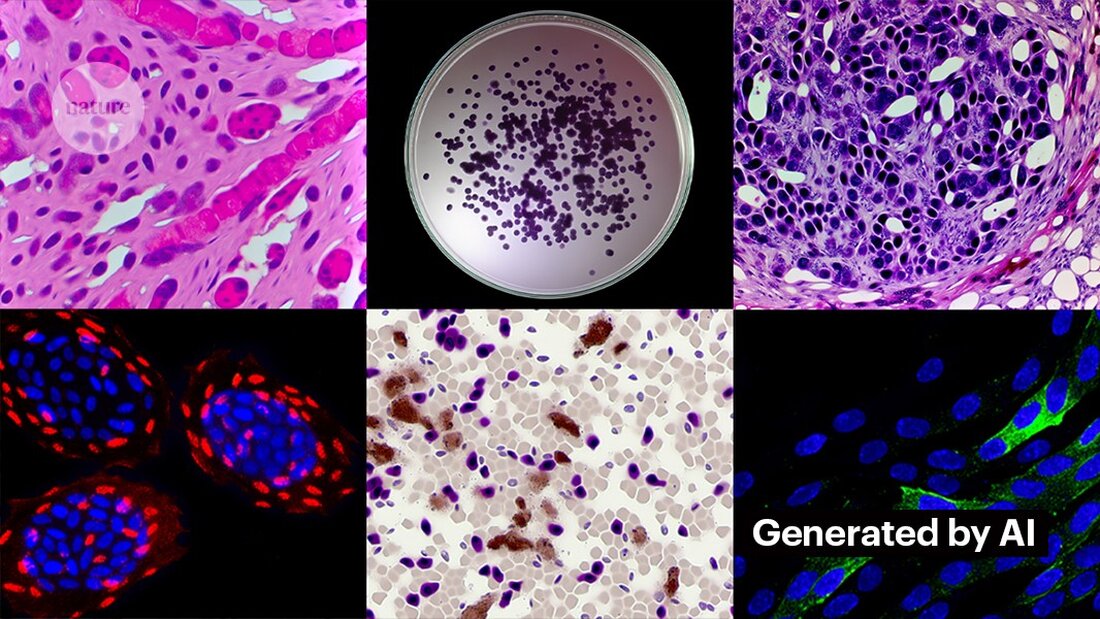

Créer des images nettes avec l’IA générative n’est pas difficile. Kevin Patrick, un détective d'images scientifiques connu sous le nom de Cheshire sur les réseaux sociaux, a démontré à quel point cela peut être simple et a publié ses découvertes sur X. À l'aide de l'outil d'IA de Photoshop Generative Fill, Patrick a créé des images réalistes - qui pourraient apparaître dans des articles scientifiques - de tumeurs, de cultures cellulaires, de Western blots et bien plus encore. La création de la plupart des images a pris moins d’une minute (voir « Générer de la fausse science »).

"Si je peux le faire, alors ceux qui sont payés pour créer de fausses données le feront sûrement aussi", déclare Patrick. "Il existe probablement de nombreuses autres données qui pourraient être générées à l'aide d'outils comme celui-ci."

Certains éditeurs rapportent avoir trouvé des preuves de contenu généré par l’IA dans des études publiées. Cela inclut PLoS, qui a été alerté de contenus suspects et a trouvé des preuves de textes et de données générés par l'IA dans des articles et des soumissions grâce à des enquêtes internes, explique Renée Hoch, rédactrice en chef de l'équipe d'éthique des publications de PLoS à San Francisco, en Californie. (Hoch note que l'utilisation de l'IA n'est pas interdite dans les revues PLoS et que la politique en matière d'IA est basée sur la responsabilité de l'auteur et des divulgations transparentes.)

D’autres outils pourraient également offrir des opportunités aux personnes souhaitant créer de faux contenus. Le mois dernier, des chercheurs ont publié un 1 modèle d’IA génératif pour créer des images microscopiques haute résolution – et certains spécialistes de l’intégrité ont exprimé leurs inquiétudes concernant ce travail. «Cette technologie peut facilement être utilisée par des personnes mal intentionnées pour créer rapidement des centaines, voire des milliers de fausses images», explique Bik.

Yoav Shechtman de l'Institut de technologie Technion-Israël à Haïfa, le créateur de l'outil, affirme que l'outil est utile pour créer des données de formation pour les modèles car les images microscopiques haute résolution sont difficiles à obtenir. Mais il ajoute que cela n’est pas utile pour générer des contrefaçons car les utilisateurs ont peu de contrôle sur les résultats. Les logiciels de retouche d'images existants tels que Photoshop sont plus utiles pour manipuler des figures, suggère-t-il.

Même si les yeux humains ne sont pas capables de Reconnaître les images générées par l'IA, l’IA pourrait éventuellement le faire (voir « Les images de l’IA sont difficiles à reconnaître »).

Les développeurs d'outils comme Imagetwin et Proofig, qui utilisent l'IA pour détecter les problèmes d'intégrité dans les images scientifiques, étendent leur logiciel pour filtrer les images créées par l'IA générative. Parce que ces images sont si difficiles à reconnaître, les deux sociétés créent leurs propres bases de données d’images génératives d’IA pour entraîner leurs algorithmes.

Proofig a déjà publié une fonctionnalité dans son outil permettant de reconnaître les images de microscope générées par l'IA. Le co-fondateur Dror Kolodkin-Gal à Rehovot, en Israël, affirme qu'en testant des milliers d'images réelles et générées par l'IA à partir d'articles, l'algorithme a correctement identifié les images d'IA dans 98 % du temps et a eu un taux de faux positifs de 0,02 %. Dror ajoute que l’équipe essaie maintenant de comprendre ce que détecte exactement son algorithme.

«J'ai de grands espoirs dans ces outils», déclare Christopher. Elle souligne cependant que leurs résultats doivent toujours être évalués par des experts qui peuvent vérifier les problèmes qu'ils signalent. Christopher n'a encore vu aucune preuve de la fiabilité du logiciel de reconnaissance d'images IA (l'évaluation interne de Proofig n'a pas encore été publiée). Ces outils sont « limités, mais certainement très utiles pour nous permettre d'intensifier nos efforts d'examen des soumissions », ajoute-t-elle.

De nombreux éditeurs et instituts de recherche l'utilisent déjà Preuve et Imagejumelle. Par exemple, les revues scientifiques utilisent Proofig pour vérifier les problèmes d'intégrité des images. Selon Meagan Phelan, directrice des communications pour Science à Washington DC, l'outil n'a encore découvert aucune image générée par l'IA.

Springer Nature, l'éditeur de Nature, développe ses propres outils de détection de texte et d'images, appelés Geppetto et SnapShot, qui signalent les irrégularités qui sont ensuite évaluées par les humains. (L'équipe d'actualités Nature est éditorialement indépendante de son éditeur.)

Les groupes d’édition prennent également des mesures pour réagir aux images générées par l’IA. Un porte-parole de l'Association internationale des éditeurs scientifiques, techniques et médicaux (STM) d'Oxford, au Royaume-Uni, a déclaré qu'elle prenait la question « très au sérieux » et répondait à des initiatives telles que United2Act et le STM Integrity Hub, qui aborde les problèmes actuels liés à la publication obligatoire et à d'autres problèmes d'intégrité académique.

Christopher, qui dirige un groupe de travail STM sur les altérations et les duplications d'images, affirme qu'il y a une prise de conscience croissante de la nécessité de développer des moyens de vérifier les données brutes - par exemple, en étiquetant les images prises au microscope avec des filigranes invisibles similaires à ceux utilisés. Filigranes dans les textes générés par l'IA – cela pourrait être la bonne façon. Cela nécessite de nouvelles technologies et de nouvelles normes pour les fabricants d'appareils, ajoute-t-elle.

Patrick et d'autres s'inquiètent du fait que les éditeurs n'agissent pas assez rapidement pour faire face à la menace. « Nous craignons qu'il ne s'agisse que d'une nouvelle génération de problèmes dans la littérature, auxquels ils ne s'attaqueront que lorsqu'il sera trop tard », dit-il.

Pourtant, certains sont optimistes quant au fait que le contenu généré par l’IA qui apparaît aujourd’hui dans les articles sera découvert à l’avenir.

«Je suis convaincu que la technologie s'améliorera au point de reconnaître les données créées aujourd'hui, car à un moment donné, elles seront considérées comme relativement grossières», déclare Patrick. "Les fraudeurs ne devraient pas bien dormir la nuit. Ils pourraient tromper le processus actuel, mais je ne pense pas qu'ils puissent le tromper pour toujours."

-

Saguy, A. et al. Petite méthamphétamine. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto