AI-genererede billeder i fare videnskab-Sådan vil forskere genkende dem

Forskere kæmper mod AI-genererede falske billeder i videnskabelige publikationer. Nye påvisningsmetoder udvikler sig.

AI-genererede billeder i fare videnskab-Sådan vil forskere genkende dem

Forskere manipulerer tal og masseproducerende falske papirer Obligatoriske udgivere - Problematiske manuskripter har længe været gener i videnskabelig litteratur. Videnskabelige detektiver fungerer utrætteligt, at udsætte denne forseelse og rette den videnskabelige rekord. Men deres job bliver stadig sværere, da et nyt, kraftfuldt værktøj til svindlere er kommet frem: Generativ kunstig intelligens (AI).

”Generativ AI udvikler sig meget hurtigt,” siger Jana Christopher, Billedintegritetsanalytiker hos FEBS Press i Heidelberg, Tyskland. ”Folk, der arbejder i mit område - billedintegritet og publiceringspolitikker - bliver mere og mere bekymrede over de muligheder, det præsenterer.”

Den lethed med hvilken Generative AI -værktøjstekster, billeder og data rejser frygt for en stadig mere upålidelig videnskabelig litteratur, oversvømmet med falske tal, manuskripter og konklusioner, der er vanskelige for mennesker at opdage. Et våbenløb fremkommer allerede, da integritetsspecialister, udgivere og teknologiselskaber arbejder flittigt til Udvikle AI -værktøjer, som kan hjælpe hurtigt med at identificere vildledende, AI-genererede elementer i specialartikler.

”Det er en skræmmende udvikling,” siger Christopher. ”Men der er også smarte mennesker og gode strukturelle ændringer, der foreslås.”

Forskningsintegritetseksperter rapporterer, at selv om AI-genereret tekst allerede er tilladt under visse omstændigheder fra mange tidsskrifter, kan det at bruge sådanne værktøjer til at oprette billeder eller andre data betragtes som mindre acceptabelt. ”I den nærmeste fremtid kan vi være okay med ai-genereret tekst,” siger Elisabeth Bik, image kriminalteknisk specialist og konsulent i San Francisco, Californien. ”Men jeg tegner linjen, når det kommer til at generere data.”

Bik, Christopher og andre antyder, at data, inklusive billeder, oprettet med generativ AI, allerede er vidt brugt i litteratur, og at obligatoriske udgivere bruger AI -værktøjer til at producere manuskripter i volumen (se 'Quiz: Kan du få øje på AI -forfalskninger?').

Identificering af AI-producerede billeder udgør en enorm udfordring: De er ofte næsten umulige at skelne fra rigtige billeder med det blotte øje. ”Vi føler, at vi støder på AI-genererede billeder hver dag,” siger Christopher. "Men medmindre du kan bevise det, er der virkelig meget lidt, du kan gøre."

Der er nogle klare eksempler på brugen af generativ AI i videnskabelige billeder, som Nu berygtet billede af en rotte med absurd store kønsorganer og nonsensiske etiketter, oprettet med Midjourney -billedværktøjet. Grafikken, der blev udgivet af et handelsmagasin i februar, forårsagede en storm på sociale medier og var trukket tilbage et par dage senere.

De fleste sager er dog ikke så indlysende. Tal oprettet ved hjælp af Adobe Photoshop eller lignende værktøjer inden fremkomsten af generativ AI - især i molekylær og cellulær biologi - indeholder ofte slående træk, der kan genkendes af detektiver, såsom identisk baggrund eller den usædvanlige mangel på striber eller pletter. AI-genererede tegn viser ofte ikke sådanne egenskaber. ”Jeg ser en masse papirer, der får mig til at tro, at disse vestlige blotter ikke ser ægte ud - men der er ingen rygerpistol,” siger Bik. "Alt hvad du kan sige er, at de bare ser mærkelige ud, og det er selvfølgelig ikke nok bevis til at kontakte redaktøren."

Der er dog tegn på, at AI-genererede tegn vises i offentliggjorte manuskripter. Tekster, der er skrevet ved hjælp af værktøjer som ChatGpt, øges i artikler, tydeligt ved typiske chatbot -sætninger, som forfattere glemmer at fjerne og karakteristiske ord, som AI -modeller har en tendens til at bruge. ”Så vi må antage, at dette også sker for data og billeder,” siger Bik.

En anden indikation af, at svindlere bruger sofistikerede billeddannelsesværktøjer, er, at de fleste af de problemer, som efterforskere i øjeblikket finder ud af, vises i værker, der er flere år gamle. ”I de senere år har vi set færre og færre problemer med billeder,” siger Bik. ”Jeg tror, at de fleste mennesker, der blev fanget manipulerende billeder, begyndte at skabe renere billeder.”

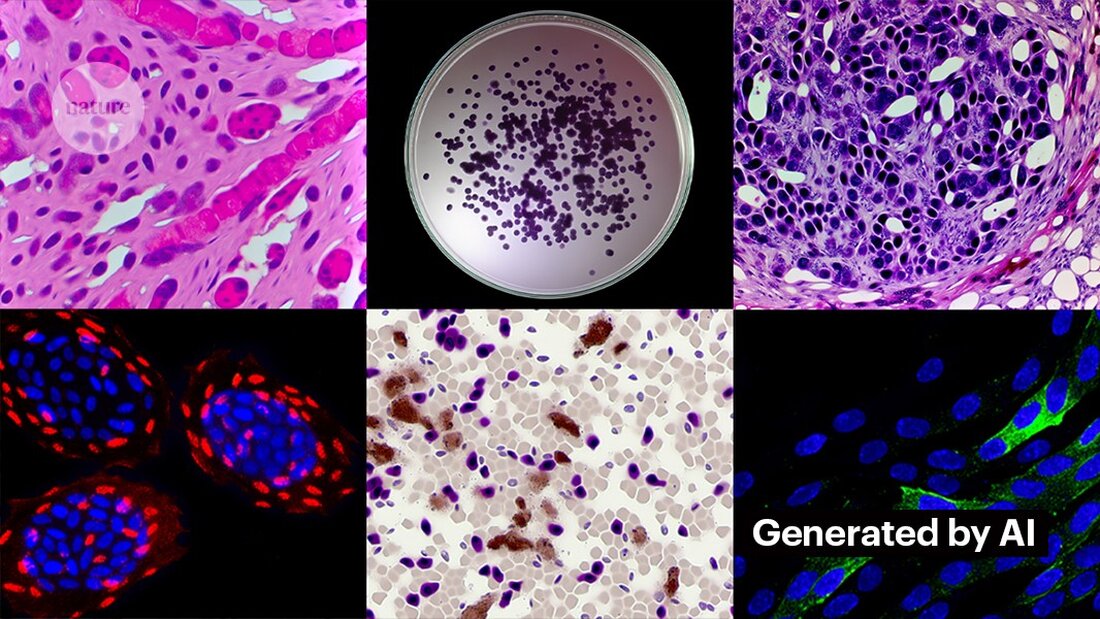

Det er ikke svært at skabe rene billeder med generativ AI. Kevin Patrick, en videnskabelig billeddetektiv kendt som Cheshire på sociale medier, har demonstreret, hvor let det kan være, og offentliggjort hans fund på X. Ved hjælp af Photoshops AI -værktøjsgenerativ fyldning skabte Patrick realistiske billeder - som kunne vises i videnskabelige papirer - af tumorer, cellekulturer, vestlige blots og mere. De fleste billeder tog mindre end et minut at skabe (se 'Generering af falsk videnskab').

”Hvis jeg kan gøre det, vil de helt sikkert også gøre for at oprette falske data,” siger Patrick. "Der er sandsynligvis en hel masse andre data, der kunne genereres ved hjælp af værktøjer som dette."

Nogle udgivere rapporterer at finde bevis for AI-genereret indhold i offentliggjorte studier. Dette inkluderer PLO'er, der er blevet advaret om mistænkeligt indhold og fundet bevis for AI-genereret tekst og data i artikler og indsendelser gennem interne undersøgelser, siger Renée Hoch, redaktør for PLOS 'publikationsetiske team i San Francisco, Californien. (Hoch bemærker, at brugen af AI ikke er forbudt i PLOS -tidsskrifter, og at AI -politikken er baseret på forfatteransvar og gennemsigtige oplysninger.)

Andre værktøjer kunne også give muligheder for mennesker, der ønsker at skabe falske indhold. Sidste måned offentliggjorde forskere en 1 Generativ AI-model til at skabe mikroskopbilleder i høj opløsning-og nogle integritetsspecialister udtrykte bekymring for dette arbejde. ”Denne teknologi kan let bruges af mennesker med dårlige intentioner til hurtigt at skabe hundreder eller tusinder af falske billeder,” siger Bik.

Yoav Shechtman fra Technion-Israel Institute of Technology i Haifa, værktøjets skaber, siger, at værktøjet er nyttigt til at oprette træningsdata til modeller, fordi mikroskopbilleder med høj opløsning er vanskelige at få. Men han tilføjer, at det ikke er nyttigt til at generere forfalskninger, fordi brugerne har lidt kontrol over resultaterne. Eksisterende billedredigeringssoftware som Photoshop er mere nyttig til at manipulere figurer, foreslår han.

Selvom menneskelige øjne muligvis ikke er i stand til det Genkend AI-genererede billeder, AI kunne muligvis gøre dette (se 'AI -billeder er vanskelige at genkende').

Udviklerne af værktøjer som ImageTwin og ProofIg, der bruger AI til at registrere integritetsproblemer i videnskabelige billeder, udvider deres software til at filtrere billeder oprettet af generativ AI. Fordi sådanne billeder er så vanskelige at genkende, opretter begge virksomheder deres egne databaser med generative AI -billeder for at træne deres algoritmer.

Proofig har allerede frigivet en funktion i sit værktøj til at genkende AI-genererede mikroskopbilleder. Medstifter Dror Kolodkin-Gal I Rehovot, Israel, siger, at algoritmen ved testning med tusinder af AI-genererede og reelle billeder fra artikler identificerede algoritmen korrekt AI-billeder 98% af tiden og havde en falsk positiv sats på 0,02%. Dror tilføjer, at holdet nu prøver at forstå, hvad deres algoritme nøjagtigt registrerer.

”Jeg har store forhåbninger til disse værktøjer,” siger Christopher. Hun bemærker imidlertid, at deres resultater altid skal evalueres af eksperter, der kan verificere de problemer, de indikerer. Christopher har endnu ikke set nogen beviser for, at AI -billedgenkendelsessoftware er pålidelig (ProofiTs interne evaluering er endnu ikke blevet offentliggjort). Disse værktøjer er "begrænsede, men bestemt meget nyttige til at give os mulighed for at skalere vores indsendelsesanmeldelsesindsats," tilføjer hun.

Mange udgivere og forskningsinstitutioner bruger det allerede Bevis og Imagetwin. F.eks. Bruger videnskabsskrifter bevis for at kontrollere integritetsproblemer i billeder. Ifølge Meagan Phelan, kommunikationsdirektør for videnskab i Washington DC, har værktøjet endnu ikke opdaget nogen AI-genererede billeder.

Springer Nature, Nature's Publisher, udvikler sine egne tekst- og billeddetektionsværktøjer, kaldet Geppetto og Snapshot, som flagger uregelmæssigheder, der derefter evalueres af mennesker. (Naturnyhedsteamet er redaktionelt uafhængigt af sin udgiver.)

Publiceringsgrupper tager også skridt til at svare på AI-genererede billeder. En talsmand for International Association of Scientific, Technical and Medical (STM) udgivere i Oxford, UK, sagde, at det tog spørgsmålet "meget alvorligt" og svarede på initiativer som f.eks. United2act og STM Integrity Hub, der adresserer aktuelle problemer med obligatorisk udgivelse og andre akademiske integritetsspørgsmål.

Christopher, der leder en STM -arbejdsgruppe om billedændringer og duplikationer, siger, at der er en voksende opmærksomhed om, at det vil være nødvendigt at udvikle måder at verificere rå data - for eksempel ved at mærke billeder taget med mikroskoper med usynlige vandmærker, der ligner dem, der bruges Vandmærker i AI-genererede tekster - Det kan være den rigtige måde. Dette kræver nye teknologier og nye standarder for enhedsproducenter, tilføjer hun.

Patrick og andre bekymrer sig for, at udgivere ikke handler hurtigt nok til at tackle truslen. ”Vi frygter, at dette bare vil være en anden generation af problemer i litteraturen, som de ikke adresserer, før det er for sent,” siger han.

Nogle er stadig optimistiske over, at det AI-genererede indhold, der vises i artikler i dag, vil blive opdaget i fremtiden.

”Jeg har enhver tillid til, at teknologien forbedres til det punkt, hvor den genkender de data, der oprettes i dag - fordi dette på et tidspunkt vil blive betragtet som relativt grov,” siger Patrick. "Svindlere skulle ikke sove godt om natten. De kunne narre den aktuelle proces, men jeg tror ikke, de kan narre processen for evigt."

-

Saguy, A. et al. Lille meth. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto