Vedci používajú techniky od astronómie na vytvorenie počítačom generovaného Obrázky „DeepFake“ Rozpoznať - ktoré na prvý pohľad môže vyzerať rovnako so skutočnými fotografiami.

Analýzou obrazov tvárí, ktoré sa zvyčajne používajú na štúdium vzdialených galaxií, môžu astronómovia zmerať, ako oči človeka odrážajú svetlo, čo môže naznačovať príznaky manipulácie s obrazom.

„Nie je to všeliek, pretože máme falošné pozitíva a falošné negatívy,“ hovorí Kevin Pimbblet, riaditeľ Centra pre vedu o údajoch, umelej inteligencie a modelovanie na University of Hull, UK. Výskum predstavil na stretnutí Národnej astronómie Kráľovskej astronomickej spoločnosti 15. júla. „Tento výskum však ponúka potenciálny spôsob, dôležitý krok vpred, potenciálne pridať k testom, ktoré možno použiť na zistenie, či je obraz skutočný alebo falošný.“

Vyjadrené fotografie

Pokroky v umelej inteligencii (AI) sťažujú rozprávať rozdiel medzi skutočnými obrázkami, videami a zvukom tie vytvorené algoritmami, rozpoznať. DeepFakes nahradia vlastnosti jednej osoby alebo životného prostredia ostatnými a môže to vyzerať, akoby jednotlivci povedali alebo robili veci, ktoré neurobili. Úrady varujú, že táto technológia militarizuje a prispieva k šíreniu dezinformácií, Napríklad počas volieb, môže byť použitý.

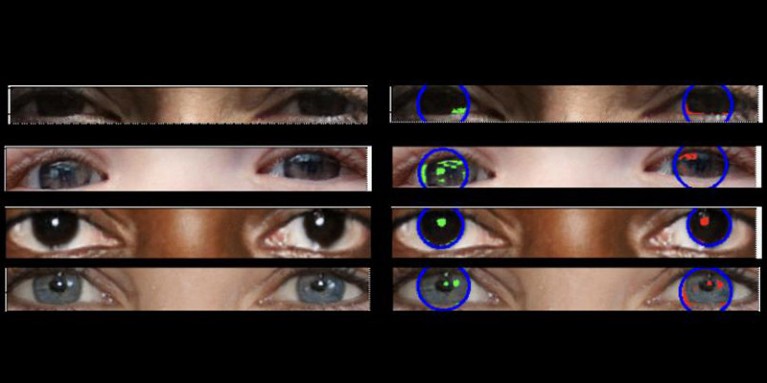

Skutočné fotografie by mali mať „konzistentnú fyziku“, vysvetľuje Pimbblet, „, takže odrazy, ktoré vidíte v ľavom oku, by mali byť veľmi podobné, aj keď nie nevyhnutne identické, s odrazmi v pravom oku“. Rozdiely sú jemné, takže vedci sa obrátili na techniky vyvinuté na analýzu svetla v astronomických obrazoch.

Práca, ktorá ešte nebola uverejnená, tvorila základ pre diplomovú tézu Adejumoke Owolabiho. Owolabi, vedec údajov na University of Hull vo Veľkej Británii, získal skutočné obrazy z Flickr Faces HQ Dataset a vytvorené falošné tváre pomocou generátora obrázkov. Owolabi potom analyzoval odrazy zo svetelných zdrojov v očiach na obrázkoch pomocou dvoch astronomických meraní: Systém CAS a index Gini. Systém CAS kvantifikuje koncentráciu, asymetriu a hladkosť distribúcie svetla objektu. Táto technika umožnila astronómom vrátane Pimbblet charakterizovať svetlo extragalaktických hviezd po celé desaťročia. Index Gini meria nerovnosť distribúcie svetla v obrazoch galaxií.

Porovnaním úvah v očiach človeka Owolabi dokázal správne predpovedať, či bol obraz falošný asi 70% času. Vedci nakoniec zistili, že index Gini bol lepší ako systém CAS pri predpovedaní, či sa s obrazom manipuloval.

Brant Robertson, astrofyzik na Kalifornskej univerzite v Santa Cruz, víta výskum. „Ak však dokážete vypočítať hodnotu, ktorá kvantifikuje, ako sa môže objaviť realistický obraz DeepFake, môžete tiež trénovať model AI tak, aby vytvoril ešte lepšie hlboké fláky optimalizáciou tejto hodnoty,“ varuje.

Zhiwu Huang, výskumný pracovník AI na University of Southampton vo Veľkej Británii, tvrdí, že jeho vlastný výskum neidentifikoval žiadne nekonzistentné svetelné vzorce v očiach obrazov hlbokomorských frekvencií. „Aj keď špecifická technika používania nekonzistentných odrazov v očných bulvách nemusí byť široko použiteľná, takéto techniky by mohli byť užitočné na analýzu jemných anomálií pri osvetlení, tieňoch a odrazoch v rôznych častiach obrazu,“ hovorí. „Zistenie nezrovnalostí vo fyzikálnych vlastnostiach svetla by mohlo doplniť existujúce metódy a zlepšiť celkovú presnosť detekcie hlbokých rúk.“

Suche

Suche

Mein Konto

Mein Konto