I ricercatori utilizzano tecniche astronomiche per creare immagini generate al computer Immagini “deepfake”. riconoscere, che a prima vista potrebbe sembrare identico alle foto reali.

Analizzando le immagini dei volti tipicamente utilizzate per studiare le galassie distanti, gli astronomi possono misurare il modo in cui gli occhi di una persona riflettono la luce, il che può indicare segni di manipolazione delle immagini.

“Non è una panacea perché abbiamo falsi positivi e falsi negativi”, afferma Kevin Pimbblet, direttore del Center for Data Science, Artificial Intelligence and Modeling presso l’Università di Hull, nel Regno Unito. Ha presentato la ricerca al National Astronomy Meeting della Royal Astronomical Society il 15 luglio. "Ma questa ricerca offre un metodo potenziale, un importante passo avanti, da aggiungere potenzialmente ai test che possono essere utilizzati per scoprire se un'immagine è reale o falsa."

Foto espresse

I progressi nell’intelligenza artificiale (AI) stanno rendendo sempre più difficile distinguere tra immagini, video e audio reali quelli creati dagli algoritmi, riconoscere. I deepfake sostituiscono le caratteristiche di una persona o di un ambiente con altre e possono far sembrare che le persone abbiano detto o fatto cose che non hanno fatto. Le autorità avvertono che questa tecnologia si sta militarizzando e contribuisce alla diffusione della disinformazione. ad esempio durante le elezioni, può essere utilizzato.

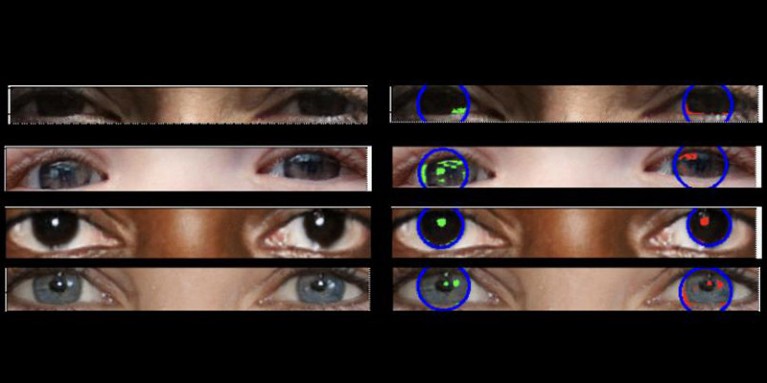

Le foto reali dovrebbero avere "una fisica coerente", spiega Pimbblet, "quindi i riflessi che vedi nel bulbo oculare sinistro dovrebbero essere molto simili, anche se non necessariamente identici, ai riflessi nel bulbo oculare destro". Le differenze sono sottili, quindi i ricercatori si sono rivolti a tecniche sviluppate per analizzare la luce nelle immagini astronomiche.

Il lavoro, non ancora pubblicato, ha costituito la base per la tesi di master di Adejumoke Owolabi. Owolabi, uno scienziato dei dati presso l'Università di Hull, nel Regno Unito, ha ottenuto immagini reali dal Set di dati HQ dei volti di Flickr e ha creato volti finti utilizzando un generatore di immagini. Owolabi ha poi analizzato i riflessi delle sorgenti luminose negli occhi nelle immagini utilizzando due misurazioni astronomiche: il sistema CAS e l'indice di Gini. Il sistema CAS quantifica la concentrazione, l'asimmetria e l'uniformità della distribuzione della luce di un oggetto. Questa tecnica ha permesso per decenni agli astronomi, incluso Pimbblet, di caratterizzare la luce delle stelle extragalattiche. L'indice di Gini misura la disuguaglianza della distribuzione della luce nelle immagini delle galassie.

Confrontando i riflessi nei bulbi oculari di una persona, Owolabi è stato in grado di prevedere correttamente se l'immagine era falsa circa il 70% delle volte. Alla fine, i ricercatori hanno scoperto che l’indice Gini era migliore del sistema CAS nel prevedere se un’immagine era stata manipolata.

Brant Robertson, astrofisico dell'Università della California, Santa Cruz, accoglie con favore la ricerca. "Tuttavia, se riesci a calcolare un valore che quantifica quanto realistica possa apparire un'immagine deepfake, puoi anche addestrare il modello AI a produrre deepfake ancora migliori ottimizzando quel valore", avverte.

Zhiwu Huang, ricercatore di intelligenza artificiale presso l’Università di Southampton, nel Regno Unito, afferma che la sua ricerca non ha identificato alcun modello di luce incoerente negli occhi delle immagini deepfake. Ma "anche se la tecnica specifica che prevede l'utilizzo di riflessi incoerenti nei bulbi oculari potrebbe non essere ampiamente applicabile, tali tecniche potrebbero essere utili per analizzare sottili anomalie nell'illuminazione, nelle ombre e nei riflessi in diverse parti di un'immagine", afferma. “Il rilevamento di incoerenze nelle proprietà fisiche della luce potrebbe integrare i metodi esistenti e migliorare la precisione complessiva del rilevamento dei deepfake”.

Suche

Suche

Mein Konto

Mein Konto