Les chercheurs utilisent des techniques issues de l'astronomie pour créer des images générées par ordinateur. Images « deepfakes » à reconnaître - qui, à première vue, peuvent sembler identiques à de vraies photos.

En analysant des images de visages généralement utilisées pour étudier des galaxies lointaines, les astronomes peuvent mesurer la façon dont les yeux d'une personne réfléchissent la lumière, ce qui peut indiquer des signes de manipulation d'images.

"Ce n'est pas une panacée car nous avons des faux positifs et des faux négatifs", déclare Kevin Pimbblet, directeur du Centre pour la science des données, l'intelligence artificielle et la modélisation à l'Université de Hull, au Royaume-Uni. Il a présenté la recherche lors de la réunion nationale d'astronomie de la Royal Astronomical Society le 15 juillet. "Mais cette recherche offre une méthode potentielle, un pas en avant important, pour potentiellement compléter les tests qui peuvent être utilisés pour découvrir si une image est réelle ou fausse."

Photos exprimées

Les progrès de l’intelligence artificielle (IA) rendent de plus en plus difficile la distinction entre les images réelles, les vidéos et l’audio. ceux créés par des algorithmes, à reconnaître. Les deepfakes remplacent les caractéristiques d’une personne ou d’un environnement par d’autres et peuvent donner l’impression que des individus ont dit ou fait des choses qu’ils n’ont pas faites. Les autorités préviennent que cette technologie est militarisée et contribue à la propagation de la désinformation, par exemple lors des élections, peut être utilisé.

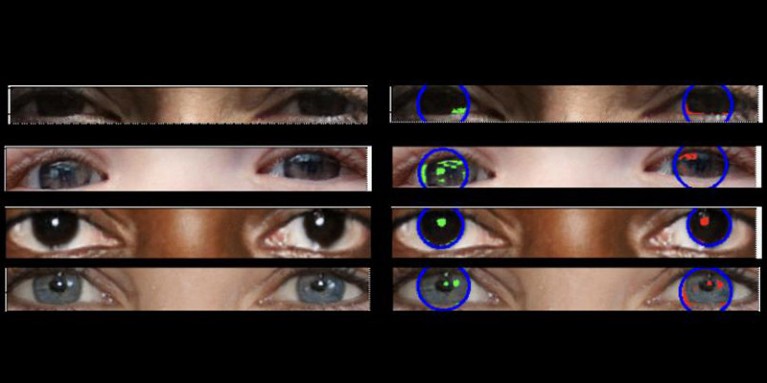

Les vraies photos doivent avoir « une physique cohérente », explique Pimbblet, « de sorte que les reflets que vous voyez dans le globe oculaire gauche doivent être très similaires, bien que pas nécessairement identiques, aux reflets dans le globe oculaire droit ». Les différences étant subtiles, les chercheurs se sont tournés vers des techniques développées pour analyser la lumière dans les images astronomiques.

Ce travail, qui n'a pas encore été publié, a constitué la base du mémoire de maîtrise d'Adejumoke Owolabi. Owolabi, un data scientist de l'Université de Hull, au Royaume-Uni, a obtenu des images réelles du Ensemble de données Flickr Faces HQ et créé de faux visages à l'aide d'un générateur d'images. Owolabi a ensuite analysé les réflexions des sources lumineuses dans les yeux sur les images à l'aide de deux mesures astronomiques : le système CAS et l'indice de Gini. Le système CAS quantifie la concentration, l'asymétrie et la douceur de la distribution lumineuse d'un objet. Cette technique permet aux astronomes, dont Pimbblet, de caractériser la lumière des étoiles extragalactiques depuis des décennies. L'indice de Gini mesure l'inégalité de répartition de la lumière dans les images de galaxies.

En comparant les reflets dans les globes oculaires d'une personne, Owolabi a pu prédire correctement si l'image était fausse dans environ 70 % des cas. En fin de compte, les chercheurs ont découvert que l’indice de Gini était meilleur que le système CAS pour prédire si une image avait été manipulée.

Brant Robertson, astrophysicien à l'Université de Californie à Santa Cruz, salue la recherche. "Cependant, si vous pouvez calculer une valeur qui quantifie le réalisme d'une image deepfake, vous pouvez également entraîner le modèle d'IA à produire des deepfakes encore meilleurs en optimisant cette valeur", prévient-il.

Zhiwu Huang, chercheur en IA à l'Université de Southampton, au Royaume-Uni, affirme que ses propres recherches n'ont identifié aucun motif lumineux incohérent dans les yeux des images deepfake. Mais "bien que la technique spécifique consistant à utiliser des reflets incohérents dans les globes oculaires ne soit pas largement applicable, de telles techniques pourraient être utiles pour analyser des anomalies subtiles dans l'éclairage, les ombres et les reflets dans différentes parties d'une image", dit-il. "La détection des incohérences dans les propriétés physiques de la lumière pourrait compléter les méthodes existantes et améliorer la précision globale de la détection des deepfakes."

Suche

Suche

Mein Konto

Mein Konto