Teadlased kasutavad arvuti loodud astronoomia tehnikaid “Deepfake” pildid ära tunda - mis esmapilgul võib olla identne tõeliste fotodega.

Analüüsides nägude pilte, mida tavaliselt kasutatakse kaugete galaktikate uurimiseks, saavad astronoomid mõõta, kuidas inimese silmad valgust peegeldavad, mis võib näidata pildi manipuleerimise tunnuseid.

"See ei ole imerohi, kuna meil on valepositiivseid ja valenegatiivid," ütleb Kevin Pimbblet, andmeteaduse, tehisintellekti ja modelleerimise keskuse direktor Suurbritannias Hulli ülikoolis. Ta esitas uuringuid kuningliku astronoomiaühingu riiklikul astronoomiakoosolekul 15. juulil. "Kuid see uurimistöö pakub potentsiaalset meetodit, olulist sammu edasi, et potentsiaalselt lisada testidele, mida saab kasutada, et teada saada, kas pilt on tõeline või võlts."

Väljendatud fotod

Tehisintellekti (AI) edusammud muudavad reaalsete piltide, videote ja heli erinevuse üha keerukamaks need, mis on loodud algoritmide poolt, ära tunda. Deepfakes asendab ühe inimese või keskkonna omadusi teistega ja võib muuta selle nii, nagu oleksid inimesed öelnud või teinud asju, mida nad ei teinud. Ametivõimud hoiatavad, et see tehnoloogia militariseerib ja aitab kaasa desinformatsiooni levikule, Näiteks valimiste ajal, saab kasutada.

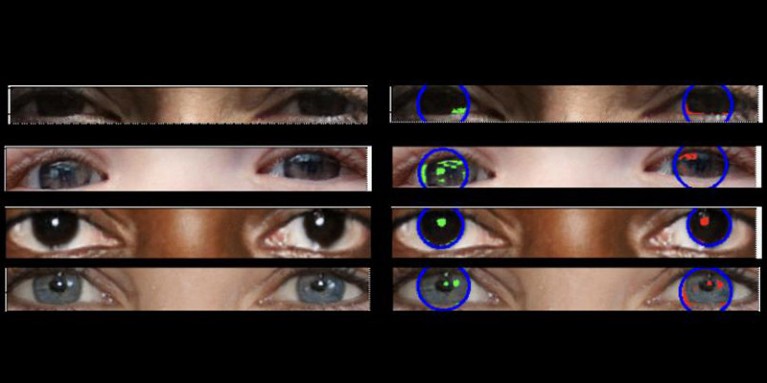

Päris fotodel peaks olema "järjepidev füüsika", selgitab Pimbblet, "nii et vasakul silmamunas nähtavad peegeldused peaksid olema paremas silmamuna peegeldustega väga sarnased, ehkki mitte tingimata identsed." Erinevused on peened, nii et teadlased pöördusid astronoomiliste piltide valguse analüüsimiseks välja töötatud tehnikate poole.

Teos, mida pole veel avaldatud, moodustas Adejumoke Owolabi magistritöö aluseks. Suurbritannia Hulli ülikooli andmeteadlane Owolabi hankis reaalseid pilte Flickr seisab peakorteri andmestikuga ja loodud võltsitud näod, kasutades pildigeneraatori. Seejärel analüüsis Owolabi piltide valgusallikate peegeldusi kahe astronoomilise mõõtmise abil: CAS -süsteem ja Gini indeks. CAS -süsteem kvantifitseerib objekti valguse jaotuse kontsentratsiooni, asümmeetria ja sujuvuse. See tehnika on võimaldanud astronoomidel, sealhulgas Pimbbletil, iseloomustada ekstragalaktiliste tähtede valgust aastakümneid. Gini indeks mõõdab galaktikate piltide valguse jaotuse ebavõrdsust.

Võrreldes inimese silmamunade peegeldusi, suutis Owolabi õigesti ennustada, kas pilt oli võlts umbes 70% ajast. Lõppkokkuvõttes leidsid teadlased, et Gini indeks oli parem kui CAS -süsteem, ennustades, kas pilt on manipuleeritud.

Brant Robertson, Santa Cruzi California ülikooli astrofüüsik, tervitab uurimistööd. "Kui aga saate arvutada väärtuse, mis kvantifitseerib, kui realistlik süvarežiimi pilt võib ilmneda, saate AI mudelit koolitada ka selle väärtuse optimeerimisega veelgi paremate sügavuste tootmiseks," hoiatab ta.

Suurbritannia Southamptoni ülikooli AI -teadlane Zhiwu Huang ütleb, et tema enda uurimistöö ei ole Deepfake'i piltide silmis tuvastanud mingeid ebajärjekindlaid valgust. Kuid "kuigi eriliste peegelduste kasutamise spetsiifiline tehnika ei pruugi laialdaselt rakendada, võiksid sellised tehnikad olla kasulikud valgustuse, varjude ja peegelduste peenete anomaaliate analüüsimiseks pildi erinevates osades," ütleb ta. "Valguse füüsiliste omaduste vastuolude tuvastamine võib täiendada olemasolevaid meetodeid ja parandada Deepfake'i tuvastamise üldist täpsust."

Suche

Suche

Mein Konto

Mein Konto