يستخدم الباحثون تقنيات من علم الفلك لإنشاء كائنات تم إنشاؤها بواسطة الكمبيوتر صور "التزييف العميق". للتعرف عليها - والتي قد تبدو للوهلة الأولى مطابقة للصور الحقيقية.

ومن خلال تحليل صور الوجوه المستخدمة عادة لدراسة المجرات البعيدة، يمكن لعلماء الفلك قياس كيفية عكس عيون الشخص للضوء، مما قد يشير إلى علامات التلاعب بالصور.

يقول كيفين بيمبليت، مدير مركز علوم البيانات والذكاء الاصطناعي والنمذجة في جامعة هال بالمملكة المتحدة: "إنه ليس علاجًا سحريًا، إذ لدينا نتائج إيجابية وسلبيات كاذبة". وقد قدم بحثه في الاجتماع الوطني لعلم الفلك التابع للجمعية الفلكية الملكية في 15 يوليو. "لكن هذا البحث يقدم طريقة محتملة، وخطوة مهمة إلى الأمام، لإضافتها إلى الاختبارات التي يمكن استخدامها لمعرفة ما إذا كانت الصورة حقيقية أم مزيفة".

صور معبرة

يؤدي التقدم في مجال الذكاء الاصطناعي (AI) إلى زيادة صعوبة معرفة الفرق بين الصور ومقاطع الفيديو والصوت الحقيقية تلك التي تم إنشاؤها بواسطة الخوارزميات ، للتعرف. تعمل تقنية التزييف العميق على استبدال ميزات شخص أو بيئة معينة بميزات أخرى، ويمكن أن تجعل الأمر يبدو كما لو أن الأفراد قالوا أو فعلوا أشياء لم يفعلوها. وتحذر السلطات من أن هذه التكنولوجيا تقوم بعسكرة الأمور وتساهم في انتشار المعلومات المضللة، على سبيل المثال خلال الانتخابات ، يمكن استخدامها.

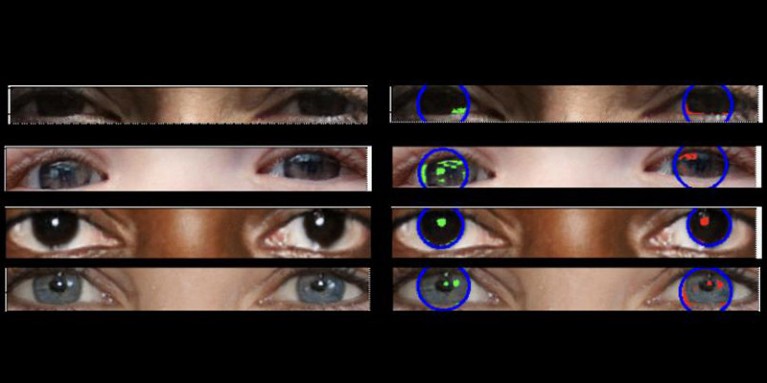

يشرح بيمبليت أن الصور الحقيقية يجب أن تحتوي على "فيزياء متسقة"، "وبالتالي فإن الانعكاسات التي تراها في مقلة العين اليسرى يجب أن تكون مشابهة جدًا، على الرغم من أنها ليست بالضرورة متطابقة، مع الانعكاسات في مقلة العين اليمنى". وكانت الاختلافات طفيفة، لذا لجأ الباحثون إلى تقنيات تم تطويرها لتحليل الضوء في الصور الفلكية.

وشكل هذا العمل، الذي لم يُنشر بعد، الأساس لأطروحة الماجستير الخاصة بأديجوموك أوولابي. حصل أوولابي، عالم البيانات في جامعة هال بالمملكة المتحدة، على صور حقيقية من مجموعة بيانات Flickr Faces HQ وإنشاء وجوه مزيفة باستخدام مولد الصور. ثم قام أوولابي بتحليل الانعكاسات من مصادر الضوء في العيون في الصور باستخدام قياسين فلكيين: نظام CAS ومؤشر جيني. يقوم نظام CAS بقياس التركيز وعدم التماثل والسلاسة في توزيع ضوء الجسم. وقد سمحت هذه التقنية لعلماء الفلك، بما في ذلك بيمبليت، بتوصيف ضوء النجوم خارج المجرة لعقود من الزمن. يقيس مؤشر جيني عدم المساواة في توزيع الضوء في صور المجرات.

ومن خلال مقارنة الانعكاسات في مقلة عيون الشخص، تمكن أوولابي من التنبؤ بشكل صحيح بما إذا كانت الصورة مزيفة في حوالي 70% من الحالات. في النهاية، وجد الباحثون أن مؤشر جيني كان أفضل من نظام CAS في التنبؤ بما إذا كان قد تم التلاعب بالصورة أم لا.

ويرحب برانت روبرتسون، عالم الفيزياء الفلكية بجامعة كاليفورنيا في سانتا كروز، بالبحث. ويحذر قائلاً: "ومع ذلك، إذا كان بإمكانك حساب قيمة تحدد مدى واقعية صورة التزييف العميق، فيمكنك أيضًا تدريب نموذج الذكاء الاصطناعي لإنتاج صور تزييف عميق أفضل من خلال تحسين تلك القيمة".

يقول زيوو هوانغ، الباحث في مجال الذكاء الاصطناعي في جامعة ساوثهامبتون بالمملكة المتحدة، إن بحثه الخاص لم يحدد أي أنماط ضوئية غير متناسقة في عيون الصور المزيفة. ولكن "في حين أن التقنية المحددة لاستخدام الانعكاسات غير المتناسقة في مقل العيون قد لا تكون قابلة للتطبيق على نطاق واسع، فإن مثل هذه التقنيات يمكن أن تكون مفيدة لتحليل الحالات الشاذة الدقيقة في الإضاءة والظلال والانعكاسات في أجزاء مختلفة من الصورة"، كما يقول. "إن اكتشاف التناقضات في الخصائص الفيزيائية للضوء يمكن أن يكمل الأساليب الحالية ويحسن الدقة الإجمالية للكشف عن التزييف العميق."

Suche

Suche

Mein Konto

Mein Konto