Maschinenlernen-Pioniere gewinnen den Nobelpreis für Physik

John Hopfield und Geoffrey Hinton gewinnen den Nobelpreis für Physik 2024 für ihre Beiträge zur Maschinenintelligenz und KI.

Maschinenlernen-Pioniere gewinnen den Nobelpreis für Physik

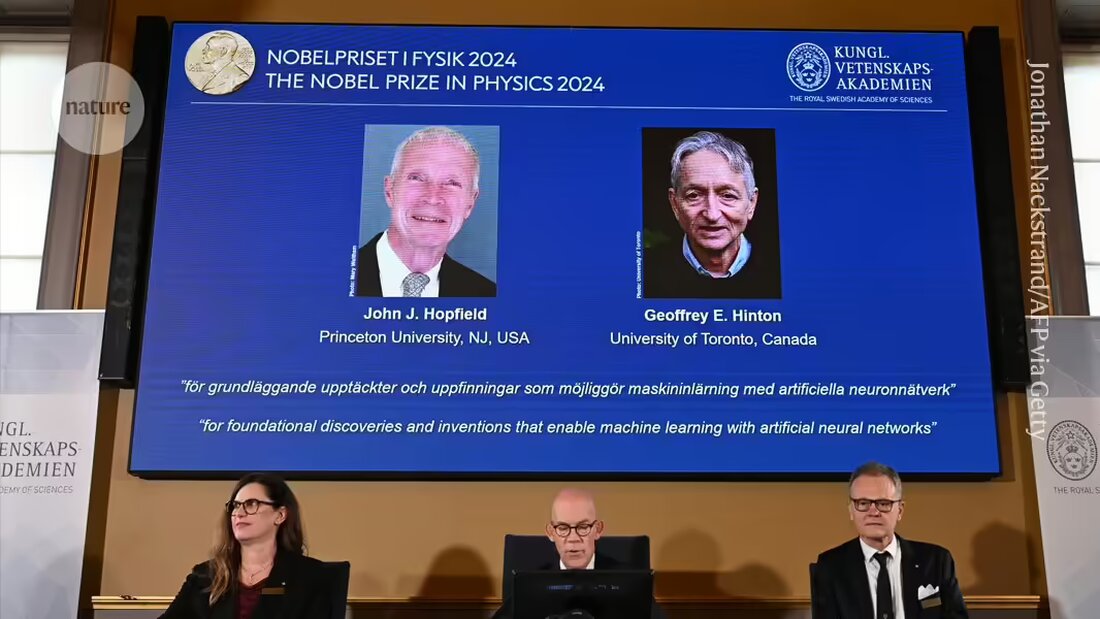

Zwei Forscher, die Maschinenlernverfahren entwickelt haben, die dem heutigen Boom in der Künstlichen Intelligenz (KI) zugrunde liegen, wurden mit dem Nobelpreis für Physik 2024 ausgezeichnet.

John Hopfield von der Princeton University in New Jersey und Geoffrey Hinton von der University of Toronto, Kanada, teilen sich den Preis von 11 Millionen Schwedischen Kronen (1 Million US-Dollar), der am 8. Oktober von der Königlich Schwedischen Akademie der Wissenschaften in Stockholm bekannt gegeben wurde.

Beide verwendeten physikalische Werkzeuge, um Methoden zu entwickeln, die künstliche neuronale Netzwerke antreiben, die Gehirn-inspirierte, geschichtete Strukturen nutzen, um abstrakte Konzepte zu lernen. Ihre Entdeckungen „bilden die Bausteine des maschinellen Lernens, das Menschen helfen kann, schnellere und zuverlässigere Entscheidungen zu treffen“, sagte Ellen Moons, Vorsitzende des Nobelkomitees und Physikerin an der Universität Karlstad, Schweden, während der Bekanntgabe. „Künstliche neuronale Netzwerke wurden verwendet, um die Forschung in verschiedenen physikalischen Themen voranzutreiben, von der Teilchenphysik über Materialwissenschaften bis hin zur Astrophysik.“

Im Jahr 1982 entwickelte Hopfield, ein theoretischer Biologe mit Hintergrund in der Physik, ein Netzwerk, das die Verbindungen zwischen Knoten als physikalische Kräfte beschrieb1. Indem es Muster als einen Niedrigenergie-Zustand des Netzwerks speicherte, konnte das System das Bild wiederherstellen, wenn es mit einem ähnlichen Muster konfrontiert wurde. Es wurde als assoziative Erinnerung bekannt, da es dem Gehirn ähnelt, das versucht, sich an ein selten verwendetes Wort oder Konzept zu erinnern.

Hinton, ein Informatiker, nutzte später Prinzipien aus der statistischen Physik, die zur kollektiven Beschreibung von Systemen verwendet werden, die aus zu vielen Einzelteilen bestehen, um die „Hopfield-Netzwerke“ weiterzuentwickeln. Durch die Integration von Wahrscheinlichkeiten in eine geschichtete Version des Netzwerks schuf er ein Werkzeug, das in der Lage war, Bilder zu erkennen und zu klassifizieren oder neue Beispiele des Typs zu generieren, auf dem es trainiert wurde2.

Diese Prozesse unterschieden sich von den vorherigen Berechnungen, da die Netzwerke in der Lage waren, aus Beispielen zu lernen, einschließlich unstrukturierter Daten, die für herkömmliche Software, die auf schrittweisen Berechnungen basiert, eine Herausforderung darstellt.

Die Netzwerke sind „großzügig idealisierte Modelle, die so unterschiedlich von echten biologischen neuronalen Netzwerken sind wie Äpfel von Planeten“, schrieb Hinton im Jahr 2000 in Nature. Aber sie haben sich als nützlich erwiesen und wurden weitreichend weiterentwickelt. Neuronale Netzwerke, die menschliches Lernen nachahmen, bilden die Grundlage vieler hochentwickelter KI-Tools, von großen Sprachmodellen (LLMs) bis hin zu maschinellen Lernalgorithmen, die in der Lage sind, große Datenmengen zu analysieren, einschließlich des Proteinstrukturvorhersagemodells AlphaFold.

In einem Telefongespräch bei der Bekanntgabe sagte Hinton, dass es „ein Blitz aus heiterem Himmel“ war, als er von seinem Nobelpreis erfuhr. „Ich bin verblüfft, ich hatte keine Ahnung, dass das geschehen würde“, sagte er. Er fügte hinzu, dass Fortschritte im maschinellen Lernen „einen enormen Einfluss haben werden; es wird mit der Industriellen Revolution vergleichbar sein. Aber anstatt den Menschen in physischer Stärke zu übertreffen, wird es die Menschen in der intellektuellen Fähigkeit übertreffen.“

-

Hopfield, J.J., Proc. Natl. Acad. Sci. USA 79, 2554 (1982).

-

Fahlman, S.E., Hinton, G.E. und Sejnowski, T.J. Proceedings of the AAAI-83 conference, S. 109-113 (1983).

Suche

Suche

Mein Konto

Mein Konto