Brecha informática de IA: los científicos carecen de acceso a chips potentes para sus investigaciones

Los académicos de todo el mundo luchan contra una potencia informática insuficiente para la investigación de la IA. Una encuesta muestra grandes diferencias en el acceso a las GPU.

Brecha informática de IA: los científicos carecen de acceso a chips potentes para sus investigaciones

Muchos científicos universitarios se sienten frustrados por la limitada potencia informática de que disponen para sus investigaciones en el campo de la inteligencia artificial (IA) está disponible, como lo muestra una encuesta realizada a académicos en docenas de instituciones en todo el mundo.

Los resultados 1, publicado el 30 de octubre en el servidor de preimpresión arXiv, sugiere que los académicos carecen de acceso a los sistemas informáticos más avanzados. Esto podría afectar su capacidad para modelos de lenguaje grandes (LLM) desarrollar y llevar a cabo otros proyectos de investigación en IA.

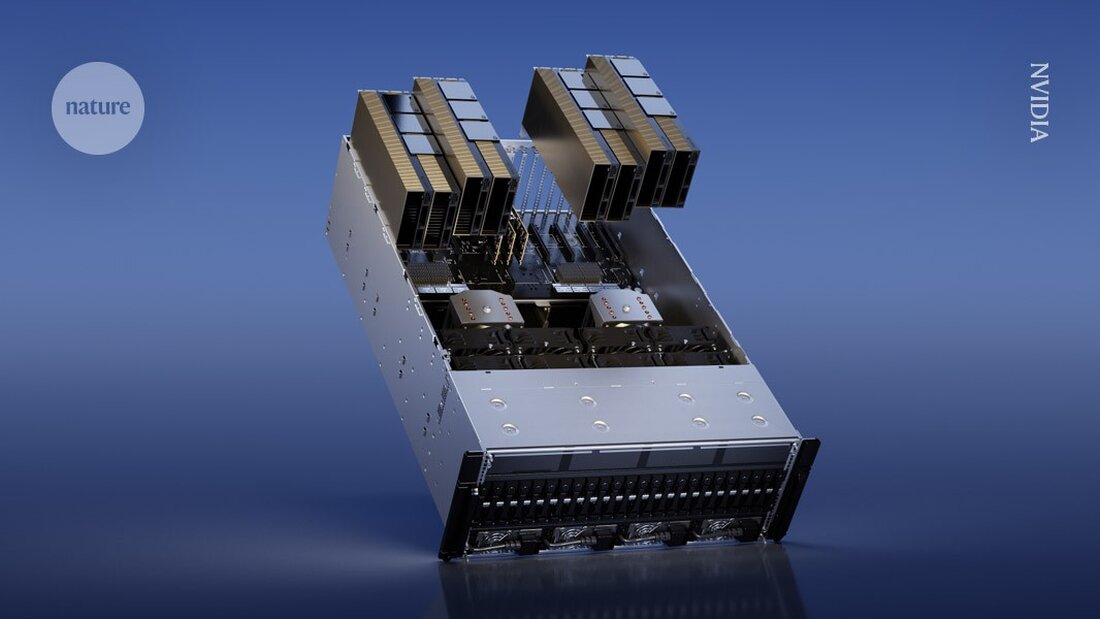

En particular, los investigadores académicos a veces no tienen los recursos para ser poderosos. Procesadores gráficos (GPU) comprar: chips de computadora comúnmente utilizados para entrenar modelos de IA que pueden costar varios miles de dólares. Por el contrario, los investigadores de las grandes empresas de tecnología tienen presupuestos mayores y pueden gastar más en GPU. "Cada GPU añade más potencia", afirma el coautor del estudio Apoorv Khandelwal, científico informático de la Universidad de Brown en Providence, Rhode Island. "Si bien estos gigantes de la industria pueden tener miles de GPU, es posible que los académicos solo tengan unas pocas".

"La brecha entre los modelos académico e industrial es grande, pero podría ser mucho menor", dice Stella Biderman, directora ejecutiva de EleutherAI, un instituto de investigación de IA sin fines de lucro en Washington DC. La investigación sobre esta desigualdad es "muy importante", añade.

Tiempos de espera lentos

Para evaluar los recursos informáticos disponibles para los académicos, Khandelwal y sus colegas encuestaron a 50 científicos de 35 instituciones. De los encuestados, el 66% calificó su satisfacción con su potencia informática con 3 o menos en una escala de 5. "No están nada satisfechos", dice Khandelwal.

Las universidades tienen diferentes regulaciones para el acceso a las GPU. Algunos pueden tener un clúster de cómputo central compartido entre departamentos y estudiantes donde los investigadores pueden solicitar tiempo de GPU. Otras instituciones podrían comprar máquinas que los miembros del laboratorio puedan utilizar directamente.

Algunos científicos informaron haber tenido que esperar días para obtener acceso a las GPU, y señalaron que los tiempos de espera eran particularmente altos cuando se acercaban las fechas límite de los proyectos (consulte “Cuello de botella en los recursos informáticos”). Los resultados también resaltan las desigualdades globales en el acceso. Por ejemplo, un encuestado mencionó la dificultad de encontrar GPU en Medio Oriente. Sólo el 10% de los encuestados afirmó tener acceso a GPU H100 de NVIDIA, tener potentes chips diseñados para la investigación de la IA.

Esta barrera hace que el proceso de capacitación previa (introducir grandes conjuntos de datos en los LLM) sea particularmente desafiante. "Es tan caro que la mayoría de los académicos ni siquiera consideran hacer ciencia en la formación previa", dice Khandelwal. Él y sus colegas creen que los académicos ofrecen una perspectiva única en la investigación de la IA y que la falta de acceso a la potencia informática podría limitar el campo de la investigación.

"Es realmente importante tener un entorno de investigación académica saludable y competitivo para el crecimiento y el desarrollo tecnológico a largo plazo", dice la coautora Ellie Pavlick, que estudia informática y lingüística en la Universidad de Brown. "Cuando se investiga en la industria, existen claras presiones comerciales que a veces te tientan a explotar más rápido y explorar menos".

Métodos eficientes

Los investigadores también examinaron cómo los académicos podrían hacer un mejor uso de recursos informáticos menos potentes. Calcularon cuánto tiempo se necesitaría para entrenar previamente varios LLM utilizando hardware de bajos recursos: entre 1 y 8 GPU. A pesar de estos recursos limitados, los investigadores lograron entrenar con éxito muchos de los modelos, aunque llevó más tiempo y requirió el uso de métodos más eficientes.

"De hecho, podemos utilizar las GPU que tenemos durante más tiempo, y así podemos suavizar algunas de las diferencias entre lo que tiene la industria", afirma Khandelwal.

"Es emocionante ver que realmente se puede entrenar un modelo más grande de lo que mucha gente imaginaría, incluso con recursos informáticos limitados", afirma Ji-Ung Lee, que estudia modelos neuroexplícitos en la Universidad de Saarland en Saarbrücken, Alemania. Añade que el trabajo futuro podría analizar las experiencias de investigadores industriales en pequeñas empresas que también luchan por el acceso a los recursos informáticos. "No es que todos los que tienen acceso a potencia informática ilimitada realmente la tengan", afirma.

-

Khandelwal, A. et al. Preimpresión en arXiv https://doi.org/10.48550/arXiv.2410.23261 (2024).

Suche

Suche

Mein Konto

Mein Konto