Pesquisadores usam técnicas da astronomia para criar imagens geradas por computador Imagens “deepfake” reconhecer - que à primeira vista podem parecer idênticas às fotos reais.

Ao analisar imagens de rostos normalmente usados para estudar galáxias distantes, os astrônomos podem medir como os olhos de uma pessoa refletem a luz, o que pode indicar sinais de manipulação de imagem.

“Não é uma panacéia, pois temos falsos positivos e falsos negativos”, diz Kevin Pimbblet, diretor do Centro de Ciência de Dados, Inteligência Artificial e Modelagem da Universidade de Hull, no Reino Unido. Ele apresentou a pesquisa no Encontro Nacional de Astronomia da Royal Astronomical Society em 15 de julho. "Mas esta pesquisa oferece um método potencial, um importante passo em frente, para potencialmente adicionar aos testes que podem ser usados para descobrir se uma imagem é real ou falsa."

Fotos expressas

Os avanços na inteligência artificial (IA) estão tornando cada vez mais difícil diferenciar entre imagens, vídeos e áudio reais aqueles criados por algoritmos, para reconhecer. Deepfakes substituem características de uma pessoa ou ambiente por outras e podem fazer parecer que os indivíduos disseram ou fizeram coisas que não fizeram. As autoridades alertam que esta tecnologia está a militarizar e a contribuir para a propagação de desinformação, por exemplo durante as eleições, pode ser usado.

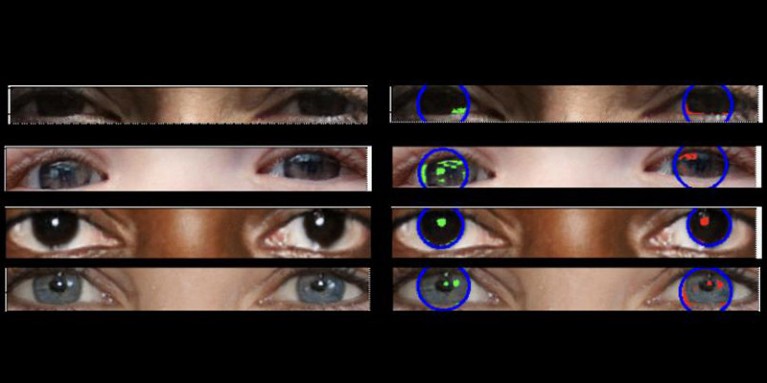

As fotos reais devem ter “física consistente”, explica Pimbblet, “de modo que os reflexos que você vê no globo ocular esquerdo devem ser muito semelhantes, embora não necessariamente idênticos, aos reflexos no globo ocular direito”. As diferenças são sutis, por isso os pesquisadores recorreram a técnicas desenvolvidas para analisar a luz em imagens astronômicas.

A obra, ainda não publicada, serviu de base para a tese de mestrado de Adejumoke Owolabi. Owolabi, cientista de dados da Universidade de Hull, Reino Unido, obteve imagens reais do Conjunto de dados HQ do Flickr Faces e criou rostos falsos usando um gerador de imagens. Owolabi então analisou os reflexos das fontes de luz nos olhos nas imagens usando duas medidas astronômicas: o sistema CAS e o índice de Gini. O sistema CAS quantifica a concentração, assimetria e suavidade da distribuição de luz de um objeto. Esta técnica permitiu aos astrónomos, incluindo Pimbblet, caracterizar a luz de estrelas extragalácticas durante décadas. O índice de Gini mede a desigualdade na distribuição da luz em imagens de galáxias.

Ao comparar os reflexos nos globos oculares de uma pessoa, Owolabi foi capaz de prever corretamente se a imagem era falsa em cerca de 70% das vezes. Em última análise, os investigadores descobriram que o índice de Gini era melhor do que o sistema CAS para prever se uma imagem tinha sido manipulada.

Brant Robertson, astrofísico da Universidade da Califórnia, em Santa Cruz, saúda a pesquisa. “No entanto, se você puder calcular um valor que quantifique o quão realista uma imagem deepfake pode parecer, você também poderá treinar o modelo de IA para produzir deepfakes ainda melhores, otimizando esse valor”, alerta.

Zhiwu Huang, pesquisador de IA da Universidade de Southampton, no Reino Unido, diz que sua própria pesquisa não identificou nenhum padrão de luz inconsistente nos olhos de imagens deepfake. Mas “embora a técnica específica de utilização de reflexos inconsistentes nos globos oculares possa não ser amplamente aplicável, tais técnicas podem ser úteis para analisar anomalias subtis na iluminação, sombras e reflexos em diferentes partes de uma imagem”, diz ele. “A detecção de inconsistências nas propriedades físicas da luz poderia complementar os métodos existentes e melhorar a precisão geral da detecção de deepfake.”

Suche

Suche

Mein Konto

Mein Konto