Forscher greifen auf Techniken aus der Astronomie zurück, um computererzeugte Obrazy „Deepfake”. rozpoznać - które na pierwszy rzut oka mogą wyglądać identycznie jak prawdziwe zdjęcia.

Analizując obrazy twarzy zwykle wykorzystywane do badania odległych galaktyk, astronomowie mogą zmierzyć, w jaki sposób oczy danej osoby odbijają światło, co może wskazywać na oznaki manipulacji obrazem.

„To nie jest panaceum, ponieważ występują fałszywie pozytywne i fałszywie negatywne wyniki” – mówi Kevin Pimbblet, dyrektor Centrum nauki o danych, sztucznej inteligencji i modelowania na Uniwersytecie w Hull w Wielkiej Brytanii. Wyniki swoich badań przedstawił 15 lipca na Krajowym Spotkaniu Astronomicznym Królewskiego Towarzystwa Astronomicznego. „Ale te badania oferują potencjalną metodę, ważny krok naprzód, który może potencjalnie dodać do testów, które można wykorzystać do sprawdzenia, czy obraz jest prawdziwy, czy fałszywy”.

Wyrażone zdjęcia

Postępy w sztucznej inteligencji (AI) sprawiają, że coraz trudniej jest odróżnić prawdziwe obrazy, filmy i dźwięk te utworzone przez algorytmy, rozpoznać. Deepfake zastępują cechy jednej osoby lub środowiska innymi i mogą sprawiać wrażenie, jakby dana osoba powiedziała lub zrobiła coś, czego nie zrobiła. Władze ostrzegają, że technologia ta militaryzuje i przyczynia się do szerzenia dezinformacji, na przykład podczas wyborów, można używać.

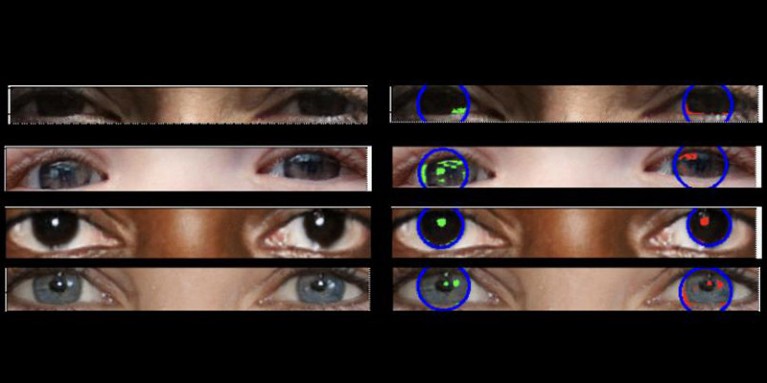

Prawdziwe zdjęcia powinny charakteryzować się „spójną fizyką” – wyjaśnia Pimbblet – „więc odbicia widoczne w lewej gałce ocznej powinny być bardzo podobne, choć niekoniecznie identyczne, z odbiciami w prawej gałce ocznej”. Różnice są subtelne, dlatego badacze sięgnęli po techniki opracowane do analizy światła na obrazach astronomicznych.

Niepublikowana dotychczas praca stała się podstawą pracy magisterskiej Adejumoke Owolabi. Owolabi, analityk danych na Uniwersytecie w Hull w Wielkiej Brytanii, pozyskał prawdziwe obrazy z witryny Zbiór danych Flickr Faces HQ i stworzył fałszywe twarze za pomocą generatora obrazów. Następnie Owolabi przeanalizował odbicia od źródeł światła w oczach na obrazach, korzystając z dwóch pomiarów astronomicznych: systemu CAS i indeksu Giniego. System CAS określa ilościowo koncentrację, asymetrię i gładkość rozkładu światła obiektu. Technika ta od dziesięcioleci pozwala astronomom, w tym Pimbbletowi, charakteryzować światło gwiazd pozagalaktycznych. Indeks Giniego mierzy nierówność rozkładu światła na obrazach galaktyk.

Porównując odbicia w gałkach ocznych danej osoby, Owolabi był w stanie poprawnie przewidzieć, czy obraz jest fałszywy w około 70% przypadków. Ostatecznie badacze odkryli, że wskaźnik Giniego lepiej niż system CAS pozwalał przewidzieć, czy obraz został zmanipulowany.

Brant Robertson, astrofizyk z Uniwersytetu Kalifornijskiego w Santa Cruz, z zadowoleniem przyjmuje badania. „Jeśli jednak potrafisz obliczyć wartość, która określa ilościowo, jak realistyczny może wyglądać obraz deepfake, możesz także wytrenować model sztucznej inteligencji, aby generował jeszcze lepsze deepfakes, optymalizując tę wartość” – ostrzega.

Zhiwu Huang, badacz sztucznej inteligencji na Uniwersytecie w Southampton w Wielkiej Brytanii, twierdzi, że jego własne badania nie wykazały żadnych niespójnych wzorów świetlnych w oczach na fałszywych obrazach. „Chociaż specyficzna technika wykorzystywania niespójnych odbić w gałkach ocznych może nie mieć szerokiego zastosowania, techniki takie mogą być przydatne do analizy subtelnych anomalii w oświetleniu, cieniach i odbiciach w różnych częściach obrazu” – mówi. „Wykrywanie niespójności we właściwościach fizycznych światła może uzupełnić istniejące metody i poprawić ogólną dokładność wykrywania deepfake”.

Suche

Suche

Mein Konto

Mein Konto