Pētnieki izmanto astronomijas paņēmienus, lai izveidotu datoru ģenerētu “DeepFake” attēli Atpazīt - kas no pirmā acu uzmetiena var izskatīties identisks reāliem fotoattēliem.

Analizējot sejas attēlus, ko parasti izmanto tālo galaktiku izpētei, astronomi var izmērīt, kā cilvēka acis atspoguļo gaismu, kas var norādīt uz attēla manipulācijas pazīmēm.

“Tā nav panaceja, jo mums ir nepatiesi pozitīvi un viltus negatīvi,” saka Kevins Pimbblets, Datu zinātnes, mākslīgā intelekta un modelēšanas centra direktors Korbulas Universitātē, Lielbritānijā. Viņš iepazīstināja ar pētījumu Karaliskās astronomiskās biedrības nacionālās astronomijas sanāksmē 15. jūlijā. "Bet šis pētījums piedāvā potenciālu metodi, kas ir svarīgs solis uz priekšu, lai potenciāli papildinātu testus, kurus var izmantot, lai noskaidrotu, vai attēls ir īsts vai viltots."

Izteiktas fotogrāfijas

Mākslīgā intelekta (AI) sasniegumi apgrūtina atšķirību starp reāliem attēliem, video un audio algoritmu radītie tie, atpazīt. DeepFakes aizstāj vienas personas vai vides īpašības ar citām un var likties tā, it kā indivīdi būtu teikuši vai izdarījuši lietas, kuras viņi nedarīja. Varas iestādes brīdina, ka šī tehnoloģija militarizē un veicina dezinformācijas izplatību, Piemēram, vēlēšanu laikā, var izmantot.

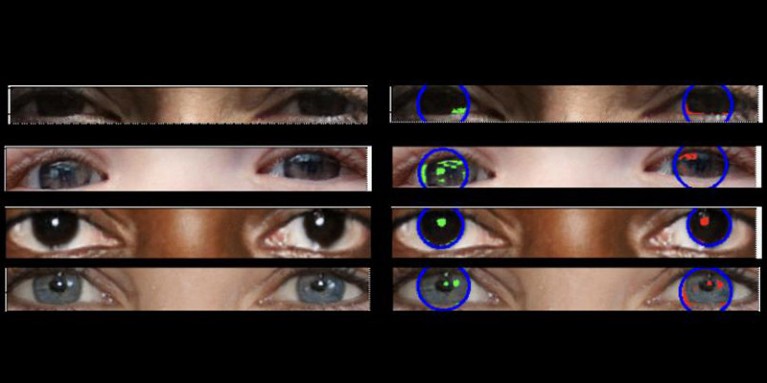

Īstām fotogrāfijām vajadzētu būt "konsekventai fizikai", skaidro Pimbblets, tāpēc kreisajā acs ābolā redzamajiem pārdomām vajadzētu būt ļoti līdzīgām, kaut arī ne vienmēr identiskām ar atstarojumiem labajā acs ābolā ". Atšķirības ir smalkas, tāpēc pētnieki pievērsās metodēm, kas izstrādātas gaismas analīzei astronomiskos attēlos.

Darbs, kas vēl nav publicēts, bija pamats Adejuumoke Owolabi maģistra disertācijai. Owolabi, datu zinātnieks Hallas universitātē, Lielbritānijā, iegūti reālus attēlus no Flickr saskaras ar HQ datu kopu un izveidoja viltotas sejas, izmantojot attēlu ģeneratoru. Pēc tam Owolabi analizēja atspoguļojumus no gaismas avotiem acīs attēlos, izmantojot divus astronomiskus mērījumus: CAS sistēmu un Džini indeksu. CAS sistēma kvantitatīvi nosaka objekta gaismas sadalījuma koncentrāciju, asimetriju un gludumu. Šis paņēmiens ļāva astronomiem, ieskaitot Pimbblet, gadu desmitiem ilgi raksturot ekstragalaktisko zvaigžņu gaismu. Džini indekss mēra gaismas sadalījuma nevienlīdzību galaktiku attēlos.

Salīdzinot pārdomas cilvēka acu ābolos, Owolabi spēja pareizi paredzēt, vai attēls ir viltots apmēram 70% laika. Galu galā pētnieki atklāja, ka Džini indekss ir labāks nekā CAS sistēma, prognozējot, vai attēls ir manipulēts.

Pētījumu atzinīgi vērtē Brants Robertsons, Kalifornijas Universitātes Santakrusa astrofiziķis. "Tomēr, ja jūs varat aprēķināt vērtību, kas kvantitatīvi nosaka, cik reāls var parādīties DeepFake attēls, varat arī apmācīt AI modeli, lai iegūtu vēl labākus DeepFakes, optimizējot šo vērtību," viņš brīdina.

Zhiwu Huang, AI pētnieks Sauthemptonas Universitātē, Lielbritānijā, saka, ka viņa paša pētījums nav identificējis nekonsekventu gaismas modeļus DeepFake attēlu acīs. Bet "kaut arī īpašā tehnika, kā acs ābolos izmantot nekonsekventus pārdomas, var nebūt plaši piemērojams, šādas metodes varētu būt noderīgas, lai analizētu smalkas anomālijas apgaismojumā, ēnās un pārdomās dažādās attēla daļās," viņš saka. "Neatbilstību noteikšana gaismas fizikālajās īpašībās varētu papildināt esošās metodes un uzlabot DeepFake noteikšanas vispārējo precizitāti."

Suche

Suche

Mein Konto

Mein Konto